技术摘要:

本发明涉及一种基于PSMNet改进的双目立体匹配方法,包括:获取双目图像,构建基于PSMNet的主干网络;该网络包括:深度卷积网络,用于提取所述双目图像的左右特征图;金字塔池化结构,用于提取所述左右特征图的多尺度目标特征;匹配代价卷,用于将多尺度目标特征进行代 全部

背景技术:

立体视觉是计算机视觉领域的一个重要课题,它的目的在于重构场景的三维几何 信息,我们可以利用双目立体相机来获得当前场景的左右视图,然后利用立体匹配算法来 计算得到当前场景的深度信息。立体匹配是立体视觉中获取目标深度信息的关键部分,其 目标是在两个或多个视点中匹配相应像素点,计算视差和深度,从而得到该场景的三维信 息。 一个完整的立体匹配算法通常包含四步:匹配代价计算、代价聚合、视差计算、视 差细化。传统的立体匹配方法主要利用局部区域法、动态规划法等方法来获得视差图,但这 类视差图往往存在很多空洞,故需要进行一系列的后处理步骤来完善视差信息和填补视差 空洞。随着深度学习大发展,视差图的获取不再拘泥于传统的立体匹配算法,而是通过设计 深度卷积网络来直接预测场景的稠密视差图。得益于卷积神经网络强大的表征能力,基于 深度学习的立体匹配算法相比于传统方法能够更加精确的对场景目标进行视差估计。 Zbontar和LeCun首次提出了使用孪生网络来计算左右视图的匹配代价,他们以一 对9×9大小的图像块作为孪生网络的输入,将该网络的输出设为左右两张图像块的相似 度,并对网络进行训练,他们的方法是一种典型的立体匹配方法计算过程,其后处理步骤包 括代价聚合、半全局匹配、视差精细化等,该方法得到的视差图相比于使用滑框进行匹配代 价计算的传统方法精度更高。Luo等人于2016年提出了更快的孪生网络来进行匹配代价的 计算,作者将匹配代价的计算视为多标签分类问题来提升推理速度。Shaked和Wolf[于2017 年提出了一种用于匹配成本计算的高速网络和一种用于预测视差置信度得分的全局视差 网络,该网络有助于进一步完善视差图。但这类基于CNN的立体匹配算法往往只是将孪生网 络用于匹配代价计算,计算后的视差值仍然需要使用后处理来提高其精度。 近几年来,研究者在立体匹配算法中的主要研究内容是利用卷积神经网络直接端 到端的生成场景视差图,摒弃了一系列的后处理优化步骤。Mayer等人2016年率先提出了端 到端的视差计算网络DispNet,并提供了一个庞大的立体匹配数据集Scene Flow供模型进 行训练。Pang等人在DispNet的基础上引入了一个称为级联残差学习(CRL)的两阶段网络, 该网络第一阶段和第二阶段分别计算视差图及其多尺度残差,然后将两个阶段的输出以求 和形成生成最终的视差图。Kendall等人于2017年提出了GCNet,该网络通过将左特征图中 的每一个像素点与右特征图中同一极线上所有可能的匹配像素进行密集比较来生成一个 尺寸为d×h×w×c的3D代价卷,然后通过3D卷积对该代价卷进行信息提取,最后通过soft- argmin操作来得到最佳匹配视差。JiaRen Cheng等人在GCNet的基础上提出了PSMNet,作者 在立体匹配网络中引入了金字塔池化结构来进行多尺度特征提取,同时在3D CNN中使用沙 漏结构来获取上下文信息,最终实现了比GCNet更优的视差效果。 3 CN 111583313 A 说 明 书 2/4 页

技术实现要素:

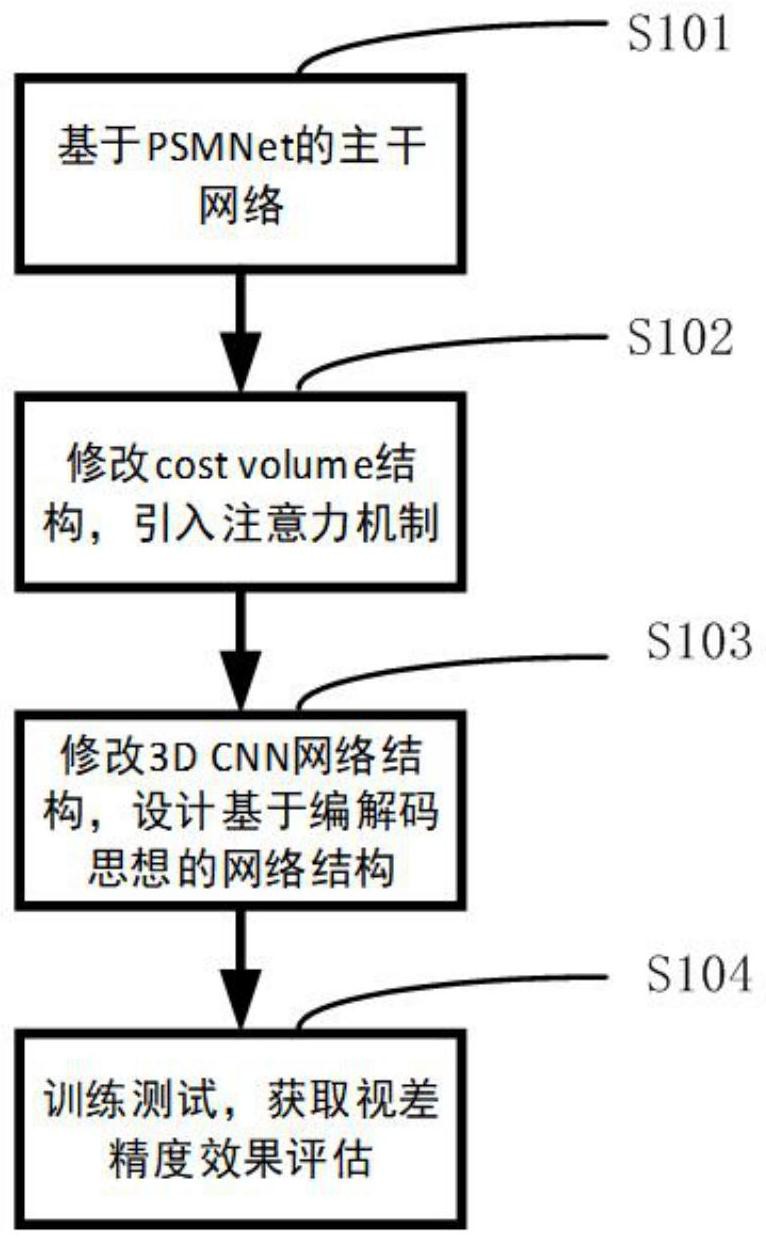

本发明所要解决的技术问题是提供一种基于PSMNet改进的双目立体匹配方法,针 对双目图像、视频能计算出高精度的视差图。 本发明解决其技术问题所采用的技术方案是:提供一种基于PSMNet改进的双目立 体匹配方法,包括: 步骤(1):获取双目图像,构建基于PSMNet的主干网络;所述基于PSMNet的主干网 络包括: 深度卷积网络,用于提取所述双目图像的特征,得到左右特征图; 金字塔池化结构,用于提取所述左右特征图的多尺度目标特征; 匹配代价卷,用于将所述左右特征图的多尺度目标特征进行代价聚合,得到3D特 征模块; 3D卷积结构,用于对所述3D特征模块进行后续代价计算; 步骤(2):通过引入通道注意力机制对网络模型提取的不同特征点赋予不同的权 重,来改进所述匹配代价卷的结构; 步骤(3):设计基于编码过程和解码过程的网络结构来改进所述3D卷积结构,得到 改进后的基于PSMNet的主干网络。 步骤(4):用所述改进后的基于PSMNet的主干网络对所述双目图像进行立体匹配。 所述步骤(2)还包括:将所述左右特征图的相似度值作为深度维的权重,所述深度 维的权重占比越大,表示对视差计算越重要。 所述左右特征图的相似度值通过度量函数进行评价,所述度量函数包括:欧氏距 离、余弦距离和Pearson相关系数。 所述步骤(3)具体为:通过加入编码过程和解码过程来构建编解码结构网络,所述 编码过程是指卷积层前向传播时,左右特征图分辨率由大到小的变化过程;所述解码过程 是指通过卷积层前向传播时,左右特征图分辨率由小到大的变化过程;所述编解码结构网 络的前半部分将数据从低维映射到高维,对数据进行编码,所述编解码结构网络的后半部 分将编码后的数据从高维映射到低维,对数据进行解码;所述编解码过程用于实现信息的 转换。 所述编码过程和解码过程中还引入了1x1卷积,所述1x1卷积将深层特征和浅层特 征融合并进行特征复用;所述1x1卷积将自动调整深层特征和浅层特征产生的差异。 所述步骤(1)中的深度卷积网络包括ResNet和PVANet深度卷积网络。 有益效果 由于采用了上述的技术方案,本发明与现有技术相比,具有以下的优点和积极效 果:本发明在匹配代价卷部分引入了注意力机制,利用左右特征图的相似度值作为深度维 的权重,以此来评价该深度维的重要程度,帮助网络在训练过程中更好的关注那些权重占 比更大、对视差计算更有用的信息,从而提高视差精度;在3D卷积结构方面改进了传统方 法,使用了编解码结构,将浅层与深层特征进行了融合,进行特征复用,使得训练时加快了 模型收敛。整体网络获得了更快的训练时间、更高的视差精度,具有较好的实用性。 4 CN 111583313 A 说 明 书 3/4 页 附图说明 图1是本发明实施方式中结构流程示意图; 图2是本发明实施方式中左右特征代价匹配中权重分配过程示意图; 图3是本发明实施方式中编解码网络结构图。