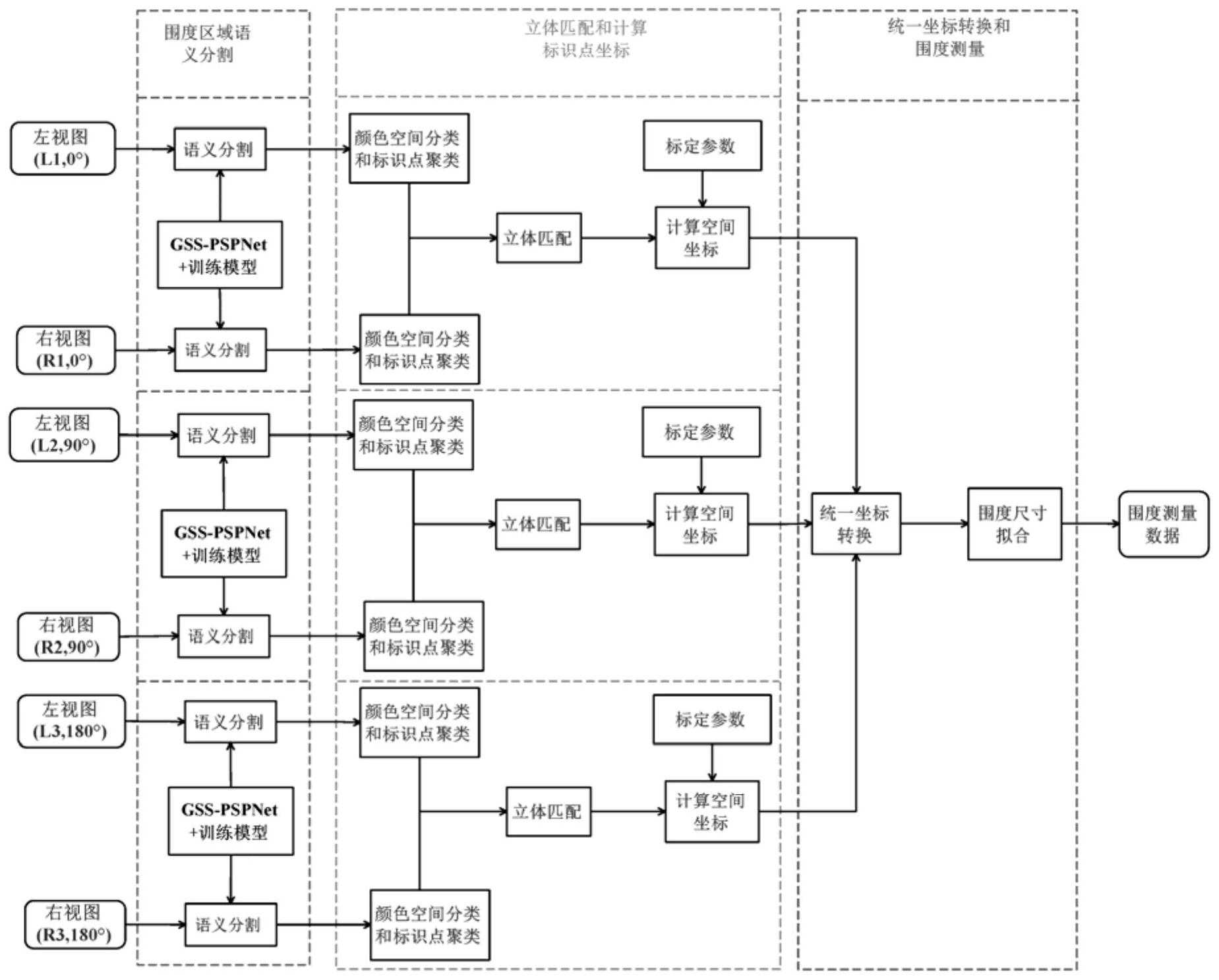

技术摘要:

本发明提出了一种基于多目视觉系统的人体围度测量方法,其步骤如下:构建GSS‑PSPNet网络模型利用数据集进行训练;搭建三组双目立体视觉系统分别拍摄被测者的彩色图像;对彩色图像的待测量围度区域进行分割;对分割图像进行HSV颜色空间分析,获得不同颜色类别的子数据 全部

背景技术:

随着信息技术的飞速发展,服装设计正朝着自动化、数字化方向发展。如今,简单 的成衣设计已经不能满足人们对个性的追求,服装设计必然趋于定制化。服装合身是影响 定制质量的主要因素。因此,必须首先对不同个体进行精确的人体测量。传统的人体测量是 用卷尺手工测量人体尺寸,具有很强的可控性和灵活性。然而,手工测量过程复杂、耗时长, 其测量误差取决于不同测量者的经验。 根据设备是否发射光源,可以将人体测量系统分为主动和被动两大类。最常见的 主动设备包括三维激光扫描仪和三维结构光扫描仪。三维激光扫描仪向被测者发射激光, 接收从被测者表面反射的激光,并且根据接收激光的位置、时间间隔和光轴角度进行精确 的人体测量。三维结构光扫描仪向被测者发射结构光,记录在被测者表面形成的干涉条纹, 并根据记录的畸变进行精确的人体测量。然而,三维结构光扫描仪通常体积大、成本高、便 携性差;此外,在数据采集过程中,设备发射的激光和结构光扫描常常会使被测者感到不舒 服。最新开发的主动设备包括Kinect和RGB-D相机,重点改进在于低成本和便携性。这些设 备向被测者发射红外光,获取深度图,并生成被测者的三维模型,从而实现人体测量。然而, 该类设备获取的深度图分辨率较低,由于缺乏几何特征,图像配准困难,重建的人体表面也 比较粗糙,人体测量精度低。最后,无论哪种主动测量设备,受试者必须保持静止不动至少 几秒钟才能完成扫描;否则,扫描图像就会变形,影响人体测量精度。 被动设备使用普通相机一次拍摄到被测者的图像,可以有效地解决这个问题。随 着视觉系统技术的进步,摄像机的成本越来越低,所采集的图像分辨率越来越高,同时具有 丰富的几何和纹理细节,可以充分利用这些图像进行人体重建和测量。

技术实现要素:

针对现有人体测量方法的成本高,重建的较粗糙,精度较低的技术问题,本发明提 出一种基于多目视觉系统的人体围度测量方法,将语义分割与立体匹配相结合,实现了简 单、准确、智能的人体围度测量。 为了达到上述目的,本发明的技术方案是这样实现的:一种基于多目视觉系统的 人体围度测量方法,其步骤如下: 步骤一:构建GSS-PSPNet网络模型并利用构建的数据集对GSS-PSPNet网络模型进 行训练:GSS-PSPNet网络模型将PSPNet网络的conv1卷积层中的7×7卷积核替换为3个3×3 串联卷积核,并利用构建的数据集对GSS-PSPNet网络模型进行训练; 步骤二:搭建三组双目立体视觉系统,将三组双目立体视觉系统分别安置在被测 者的正前方、正侧方和正后方,并利用张正友标定法对三组双目立体视觉系统分别进行标 6 CN 111598939 A 说 明 书 2/14 页 定;在被测者的待测量区域粘贴不同颜色的标识点,利用标定好的三组双目立体视觉系统 分别拍摄被测者的彩色图像; 步骤三:利用步骤一训练好的GSS-PSPNet网络模型对步骤二中获得彩色图像的待 测量围度区域进行分割和提取; 步骤四:对步骤三中的分割图像进行HSV颜色空间分析:根据标识点颜色在HSV空 间的分布情况,将分割图像中的元素根据颜色类别进行分类获得不同颜色类别的子数据 集; 步骤五:对每组双目立体视觉系统的左视图和右视图中的子数据集中的像素的ε 邻域进行聚类操作形成多个簇,并删除多余的簇,从而实现左视图中的每个簇对应右视图 中的唯一的簇; 步骤六:以步骤五中左视图中的每个簇对应右视图中的唯一的簇为匹配条件,采 用SURF方法对同一种颜色的分割图像进行立体匹配,对于在同一对簇内的多对匹配点保留 最靠近簇中心的匹配点,匹配点对的坐标就是同一标识点在左视图和右视图中的坐标; 步骤七:利用步骤六得到的坐标和步骤二中张正友标定法中双目立体视觉系统的 标定参数,获得标识点的空间坐标; 步骤八:循坏步骤五-七得到同一种颜色的标识点在三组双目立体视觉系统的空 间坐标,选取正侧方双目立体视觉系统所在的空间坐标系作为统一坐标系,将另外两组双 目立体视觉系统得到的标识点的空间坐标进行欧氏空间坐标变换,得到统一坐标系中标记 点的三维坐标; 步骤九:循环步骤八获得所有颜色子数据集中标识点在统一坐标系中的三维坐 标,将所有标记点在统一坐标系中的三维坐标信息投影到XOZ平面,并进行拟合,拟合曲线 的长度就是被测量区域的围度。 所述步骤一中PSPNet网络利用ResNet101网络进行特征提取,ResNet网络由深度 层conv1、conv2_x、conv3_x、conv4_x和conv5_x组成,将ResNet101结构中深度层conv1的7 ×7卷积核替换为3个3×3卷积核,且ResNet101结构深度层conv1的7×7卷积核和3个3×3 卷积核串联的感受野和输出大小相同,构成GSS-PSPNet网络模型; 所述构建的数据集包括:从中山大学建立的Look Into Person开源数据集中选取 的2500幅图片和用工业相机在2-4米距离拍摄的1500幅图像;然后通过随机的图像裁剪和 缩放,将数据集的大小扩展三倍,从而得到构建的数据集。 所述双目立体视觉系统中的左摄像机和右摄像机各自安装在一个平整的平面上 且成像光轴会聚、均为工业摄像机,最大分辨率1928×1448;以被测者的正前方、正侧方以 及正后方的双目立体视觉系统的左摄像机的光心为原点建立坐标系分别为0°空间坐标系、 90°空间坐标系和180°空间坐标系;在测量过程中被测者穿着紧身衣,紧身衣的测量位置表 面上镶嵌有黄色、橙色、紫色和蓝色循环排列的圆形的标识点,相邻标识点间距为1.5厘米, 且标识点只分布在面向三组双目立体视觉系统的一半测量区域。 所述步骤四中根据HSV空间分布将分割图像中的标识点分为黄色、橙色、紫色和蓝 色四种不同的颜色类别,实现方法为:分割图像中的所有像素构成一个数据集Z={z1,z2,… zi,…},i=1,2,...,n,n为像素的总数;第i个像素zi包含三个分量zi(Hi,Si,Vi);如果明度 Vi小于46,则将像素zi的三个分量Hi、Si和Vi设置为0;如果明度Vi大于46则根据其色度Hi分 7 CN 111598939 A 说 明 书 3/14 页 量对像素进行分类,并向像素zi添加表示颜色类别的第四分量Ci;其中,Hi、Si、Vi、Ci分别为 元素zi的色度H、饱和度S、明度V和颜色C分量;如果明度Vi大于46且色度Hi大于11且小于25, 则像素zi属于颜色类别橙色,Ci=orange;如果明度Vi大于46且色度Hi大于26且小于34,则 该像素属于颜色类别黄色,Ci=yellow;如果明度Vi大于46且色度Hi大于色度100小于124, 则像素zi属于颜色类别蓝色,Ci=blue;如果明度Vi大于46且色度Hi大于125且小于155,则 像素zi属于颜色类别紫色,Ci=purple; 双目立体视觉系统的左视图和右视图的分割图像中的彩色像素构成数据集Zc= {zc1,zc2,…zci,…},每个元素zci包含五个分量,即zci(Hi,Si,Vi,Ci,xi),xi为元素的水平坐 标;根据颜色类别将数据集ZC划分为四个子数据集ZCj,j=1,2,3,4,即: ZC1={zc1k∈ZC|C1k=yellow}, ZC2={zc2k∈ZC|C2k=orange}, ZC3={zc3k∈ZC|C3k=purple}, ZC4={zc4k∈ZC|C4k=blue}; 其中,zcjk为第j种颜色类别的子数据集ZCj中的第k个元素,Cjk表示第k个元素属于 第j种颜色类别。 对子数据集ZCj的第k个元素zcjk(Hjk,Sjk,Vjk,Cjk,xjk)包含5个分量,其中,Hjk,Sjk, Vjk ,Cjk ,xjk分别表示元素zcjk的色度H分量、饱和度S分量、明度V分量、颜色C分量和水平坐 标,j分别表示黄色、橙色、紫色、蓝色对应的类别;对元素zcjk的ε邻域进行聚类,形成多个 簇,每个簇对应于一个标识点,得到M个簇Mjm及簇Mjm中的像素数量Njm,m=1,2,...,M,其中, M表示子数据集ZCj中标识点的个数;计算簇Mjm中像素的平均水平坐标: 对簇Mjm进行重新排序,使 其中,xjmN表示第m个簇Mjm中第N个像 素的水平坐标。 分别对一组双目立体视觉系统的左视图和右视图的子数据集进行聚类分别获得 第j种颜色类别的簇 和簇 下标mL=1,2,...,ML,下标mR=1,2,...,MR,ML和MR分别 表示左视图和右视图的子数据集中簇的个数;如果ML等于MR,则左视图和右视图中标识点的 数目一致;如果ML比MR多1,移除个数 最小的簇 并根据平均水平坐标 对剩余的 簇进行重新排序;如果ML比MR少1,移除个数 最小的簇 并根据平均水平坐标 对 剩余的簇进行重新排序;最终,左视图的子数据集 和右视图中的子数据集 中簇的数 目相同,左视图中每个簇 对应右视图中唯一的簇 所述步骤七中标识点的空间坐标的计算方法为: 8 CN 111598939 A 说 明 书 4/14 页 其中,(xL ,yL)和(xR ,yR)分别是步骤六得到的双目立体视觉系统的左视图和右视 图的标识点的坐标,fL为左摄像机的焦距,fR为右摄像机的焦距,R为双目立体视觉系统的左 摄像机和右摄像机之间的旋转矩阵,T为双目立体视觉系统的左摄像机和右摄像机之间的 平移矢量,旋转矩阵R和平移矢量T通过张正友标定法得到,且: T=[tx ty tz]T。 所述步骤八中统一坐标系中标记点的三维坐标的计算方法为:选择正侧方的双目 立体视觉系统的90°空间坐标系作为统一坐标系,使用张正友标定法获得从0°空间坐标系 到90°空间坐标系的相对旋转矩阵R12和平移矢量T12以及从180°空间坐标系到90°空间坐标 系的相对旋转矩阵R23和平移矢量T23,利用欧氏空间坐标变换将0°空间坐标系和180°空间 坐标系的标识点分别变换到90°空间坐标系,生成一组具有统一空间坐标的标识点; 通过正前方的双目立体视觉系统拍摄图像的标识点计算0°空间坐标系下的空间 坐标,通过正侧方的双目立体视觉系统拍摄图像的标识点计算90°空间坐标系下的空间坐 标,对通过正后方的双目立体视觉系统拍摄图像的标识点计算180°空间坐标系下的空间坐 标。 三组双目立体视觉系统同时拍摄三对左视图和右视图,每对摄像机对应一个空间 坐标系,计算出三个不同坐标系中标识点的三组空间坐标分别表示为坐标系S1、S2和S3: S1={s1i|s1i=(x T1i,y1i,z1i) ,1≤i≤I}, S2={s2j|s2j=(x T2j,y2j,z2j) ,1≤j≤J}, S3={s3k|s3k=(x3k,y3k,z3k)T,1≤k≤K}, 其中,I、J、K分别表示三个不同坐标系中标识点的总数,s1i表示0°空间坐标系下的 第i个点,s2j表示90°空间坐标系下的第j个点,s3k表示180°空间坐标系下的第k个点; 把坐标系S2作为统一的坐标系,使用张正友标定法获得从坐标系S1到坐标系S2的 旋转矩阵R12和平移矢量T12: T =[-536.79 -25.63 506.18]T12 ; 计算从坐标系S2到坐标系S3的相对旋转矩阵R23和平移矢量T23: T23=[-519.35 0.589 481.25]T; 进行统一坐标系变换为: s2i=R12s1i T12,i=1,2,...,I, s =R -12k 23 (s3k-T23)k=1,2,...,K; 9 CN 111598939 A 说 明 书 5/14 页 在统一坐标系S2中统一的标识点的三维空间坐标为: S'2={s2i∪s2j∪s2k|1≤i≤I,1≤j≤J,1≤k≤K}, 其中,∪表示三个平面s2i、s2j、s3k的并集。 所述步骤九中利用引入中间变量的多项式曲线拟合方法对标识点进行曲线拟合; 所述拟合曲线被分成N1段短线段,曲线的长度L由短线段的长度ΔL i之和来近似: 其中,N1表示将拟合曲线分成N1段进行计算长度,(xi,zi)表示投影在XOZ平面的第 i1个点的坐标,(xi-1,zi-1)表示投影在XOZ平面的第i1-1个点的坐标; 假设人体是对称的,被测量的围度应为2L。 本发明的有益效果:将六个同步触发的RGB相机(R1,L1;R2,L2;R3,L3)组成三组双 目立体视觉系统分别从被测者的正面(0°)、侧面(90°)和背面(180°)同时拍摄三对立体图 像;采用一种优化的金字塔场景分析网络(PSPNet),即围度语义分割网络(GSS-PSPNet),从 每对立体图像中分割出待测围度的特定区域。只在每对立体图像中特定围度的分割区域内 进行立体匹配,以提取标识点;根据各自的标定参数,计算每对立体相机空间中标识点的实 际空间坐标。通过欧氏空间坐标变换,将三组不同空间的标识点坐标变换为同一空间;最后 对这些标识点的空间坐标进行拟合,实现围度测量。本发明利用的双目立体视觉系统体积 小,结构简单,能有效消除被测物体运动引起的测量误差,并且可以大大简化立体匹配过 程,有效提高匹配精度。 附图说明 为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现 有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本 发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以 根据这些附图获得其他的附图。 图1为本发明的流程图。 图2为本发明的三组双目立体视觉系统与被测者的分布图,其中,(a)为三维空间 视图,(b)为(a)的俯视图。 图3为本发明图2的双目立体视觉系统,其中,(a)为拍摄系统,(b)为标定板,(c)为 紧身衣。 图4为本发明复杂背景图像的SURF匹配结果图。 图5为本发明简单背景图像的SURF匹配结果图。 图6为本发明不同类型匹配点对的示例图,其中,(a)为无效匹配点对,(b)为有效 但匹配正确的点对,(c)有效正确匹配点对。 图7为本发明围度区域的统计分布图,其中,(a)为胸围区域,(b)为腰围区域。 图8为现有的PSPNet网络结构的示意图。 图9为本发明构建的GSS-PSPNet网络模型的结构示意图。 图10为本发明GSS-PSPNet网络7×7卷积核与3个3×3卷积核串联的感受野的对比 图,其中,(a)为7×7卷积核,(b)为三个3×3卷积核串联。 10 CN 111598939 A 说 明 书 6/14 页 图11为本发明数据集图像示例图。 图12为本发明人体立体图像的语义分割效果图,其中,(a)为左视点图像分割结 果,(b)为右视点图像分割结果,(c)为左右视点图像中胸部区域,(d)为左右视点图像中腰 部区域。 图13为本发明基于SURF的图像匹配结果图,其中,(a)为胸部,(b)为腰部。 图14为本发明分割图像的HSV空间散点图,其中,(a)为胸部区域色彩分布,(b)为 腰部区域色彩分布。 图15为本发明颜色子空间分类得到的四个子数据集,其中,(a)为左视点中四种颜 色标识点的提取结果,(b)为右视点中四种颜色标识点的提取结果。 图16为本发明利用簇约束条件的SURF匹配结果示意图,其中,(a)为胸部,(b)为腰 部。 图17为本发明双目立体视觉系统组成的会聚式立体视觉模型的示意图。 图18为本发明曲线拟合的结果图,其中,(a)为女性胸围,(b)为女性腰围,(c)为男 性胸围,(d)为男性腰围。