技术摘要:

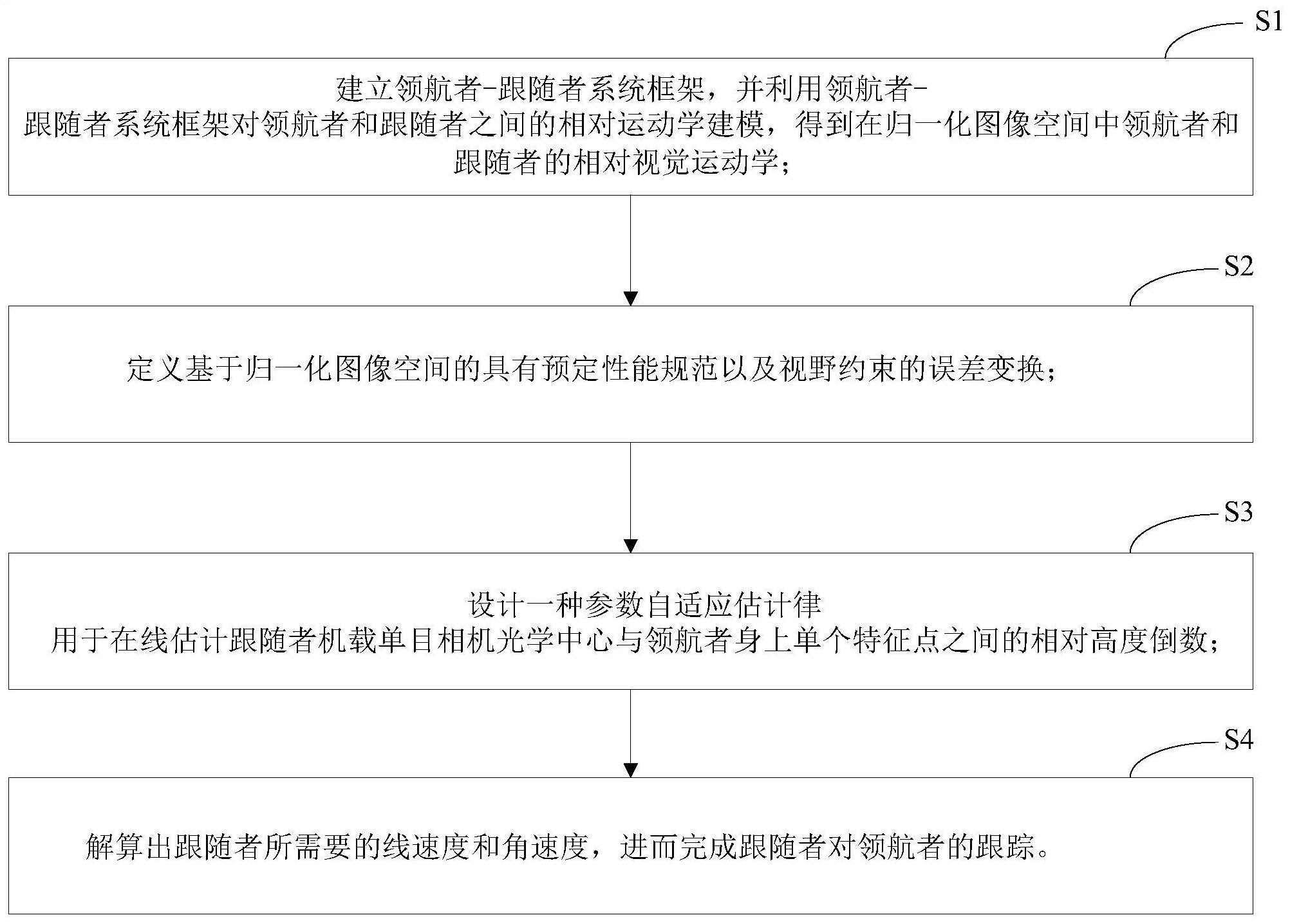

本发明公开了一种视野约束下基于图像的移动机器人编队控制方法,包括以下步骤:S1、建立领航者‑跟随者系统框架,并利用领航者‑跟随者系统框架对领航者和跟随者之间的相对运动学建模,得到在归一化图像空间中领航者和跟随者的相对视觉运动学;S2、定义基于归一化图像 全部

背景技术:

多移动机器人编队控制在处理复杂任务时,常常表现出高效率,强鲁棒性与安全 性等特点,被广泛应用于工业生产、地形探测和灾难应对等领域。多移动机器人编队控制策 略主要分为四类:领航者-跟随者方法,基于行为的方法,虚拟结构方法和滚动时域控制(或 模型预测控制)方法。其中,领航者-跟随者方法因为其实现的简单性和应用的可伸缩性,被 广为关注。但是,在领航者-跟随者编队控制中的大多数先前工作都假定每个机器人的全局 位置信息是已知的,并且机器人之间的通信可用。在GPS受限和通信退化的环境中,编队控 制问题变得更具挑战,期望扩大应用范围并改善机器人编队的自主性。与其他传统传感器 相比,视觉相机可以以较低的成本提供更丰富的信息,从而使视觉相机在仅使用机载感应 器的编队控制中被作为一个非常受欢迎的感应器选择。 各种基于视觉的领航者-跟随者编队控制方法可以归纳为两种类型:基于位置的 视觉伺服(PBVS)和基于图像的视觉伺服(IBVS)。在PBVS方法中,利用车载视觉信息重建领 航者与追随者之间的相对姿态。与PBVS方法相比,IBVS方法通过直接控制当前图像坐标和 期望图像坐标的误差来实现对领航者期望姿势的跟踪。因此,IBVS方法更适用于移动机器 人的编队控制,因为它对相机校准和对象模型错误不太敏感。但是基于视觉的控制方法存 在机载摄像机固有的有限视野的问题,这对系统的控制施加了额外的视野约束。

技术实现要素:

本发明的目的在于提供一种视野约束下基于图像的移动机器人编队控制方法,其 不需要估计领航者与跟随者之间的相对角度、位置以及领航者的角速度和线速度,并且所 提出的参数自适应估计律的计算复杂度非常低,计算简便。 本发明的目的通过以下技术方案实现:提供一种视野约束下基于图像的移动机器 人编队控制方法,包括以下步骤: S1、建立领航者-跟随者系统框架,并利用领航者-跟随者系统框架对领航者和跟 随者之间的相对运动学建模,得到在归一化图像空间中领航者和跟随者的相对视觉运动 学; S2、定义基于归一化图像空间的具有预定性能规范以及视野约束的误差变换; S3、设计一种参数自适应估计律用于在线估计跟随者机载单目相机光学中心与领 航者身上单个特征点之间的相对高度倒数; S4、解算出跟随者所需要的角速度和线速度,进而完成跟随者对领航者的跟踪。 作为进一步的改进,所述步骤S1具体包括以下内容: S11、建立领航者-跟随者框架,将领航者相对于跟随者框架的位置定义为: 5 CN 111552293 A 说 明 书 2/9 页 式中,rlf=[xlf,y Tlf] 为领航者相对于跟随者的位置,xlf和ylf分别表示相对位置的 横坐标和纵坐标,T表示矩阵转置,在世界坐标系内rl为领航者的位置,rf为跟随者的位置, θf为跟随者的方位; S12、对公式(1)求一阶微分得到领航者相对于跟随者的速度为: 式中, 为xlf的一阶微分, 为ylf的一阶微分,ωf为跟随者的角速度,vl为领航 者的线速度,vf为跟随者的线速度,ωl为领航者的角速度,θlf表示领航者和跟随者之间的 相对角度, 为θlf的一阶微分,其中: θlf=θl-θf (3) 式中,θl表示领航者的方位; S13、领航者身上单个特征点在跟随者机载单目相机框架中的归一化坐标定义为: 式中,P=[X,Y,Z]T为领航者身上单个特征点相对于跟随者机载单目相机框架中 的三维位置坐标,T表示矩阵转置,p和q分别表示特征点在归一化图像空间的横坐标和纵坐 标; S14、归一化图像空间中领航者和跟随者的相对视觉运动学为: 式中, 为p的一阶微分, 为q的一阶微分,h为跟随者机载单目相机的光学中心 与领航者身上单个特征点之间的相对高度,且 为s=[p,q]T的一阶微分,s=[p,q]T为归一 化图像坐标。 作为进一步的改进,所述步骤S2中误差变换ε的计算过程如下: S21、输入领航者的特征点在跟随者机载单目相机框架中的期望恒定视觉特征向 量s*=[p*,q*]T,其中,p*和q*分别表示特征点在归一化图像空间期望的横坐标和纵坐标; S22、利用霍夫圆检测技术实时获取领航者身上单个特征点在跟随者机载单目相 机框架中的图像平面坐标[m,n]T,则归一化图像坐标s=[p,q]T和图像平面坐标[m,n]T的关 系如下所示: 6 CN 111552293 A 说 明 书 3/9 页 其中,am、an分别为图像在水平方向和垂直方向上的尺度因子,且am>0,an>0,[m0 , n ]T0 是图像平面的主点坐标,m0、n0分别为图像平面主点的横坐标和纵坐标,m、n分别为特征 点在图像空间的横坐标和纵坐标; S23、令图像误差向量为e=[e ,e ]T1 2 ,实时测量跟随者机载单目相机框架中的归一 化图像坐标s=[p,q]T与期望恒定视觉特征向量s*=[p*,q*]T的误差,其中: e=[e1,e2]T=[p-p*,q-q*]T (7) S24、用性能函数ρk定义图像误差向量e中的图像误差ek的边界: 其中,Ck和 为正参数,k={1,2},且性能函数ρk由下式定义: 式中,ρ∞>0表示最终误差界参数,e-lt为关于参数l>0的指数衰减函数; S25:定义具有预定性能规范以及视野约束的误差变换εk: 其中,ξk=ek/ρk,k={1,2}。 作为进一步的改进,所述步骤S3的具体内容为: S31、对公式(7)中图像误差向量e求一阶微分式: 其中,λ=1/h,G表示矩阵,f表示向量,且G和f的表达式分别为: S32、误差变换向量ε=[ε ,ε]T1 2 的一阶微分式为: 其中,J表示,δ表示,且 和 被定义为: 7 CN 111552293 A 说 明 书 4/9 页 式(15)和(16)中 为ρk的一阶微分; S33、对于h的估计,间接用 估计λ=1/h,参数自适应估计律为: 其中, 为 的一阶微分,εT为ε的转置矩阵,sgn(h)为关于参数h的符号函数,|h| 的上下限定义为 上限 下限h均为正参数,g=[pq,q2]T,γ为正参数。 作为进一步的改进,所述步骤S4具体包括以下步骤: S41、为了使跟随者跟踪领航者,定义 如下: 式中, 表示vf的平均值, 表示ωf的平均值,T表示矩阵转置,T表示矩阵转置, K1、K2分别为正定矩阵; S42、为了使跟随者跟踪领航者,令跟随者的角速度和线速度输入如下: S43、通过公式(19)解算出跟随者所需要的角速度和线速度。 与现有技术相比,本发明具有以下有益效果: 1)所设计的解决方案只需要最小的感测功能,因为它仅依赖与跟随者身上的一台 单目摄像机和与领航者相连的一个特征点。 2)设计的编队控制方法不需要估计领航者与跟随者之间的相对角度、位置以及领 航者的速度,计算简便。 3)直接在图像空间中处理视野约束,选择具有预定性能规范以及视野约束的性能 函数定义误差变换,所提出的策略可确保图像误差在指定的瞬态和稳态性能指标下收敛, 并且不会违反视野约束。 附图说明 利用附图对本发明作进一步说明,但附图中的实施例不构成对本发明的任何限 8 CN 111552293 A 说 明 书 5/9 页 制,对于本领域的普通技术人员,在不付出创造性劳动的前提下,还可以根据以下附图获得 其它的附图。 图1为本发明实施例提供的一种视野约束下基于图像的移动机器人编队控制方法 的流程图。 图2为本发明实施例提供的一种视野约束下基于图像的移动机器人编队控制方法 的原理图。 图3为本发明实施例的领航者-跟随者系统框架示意图。 图4为本发明实施例的领航者和跟随者在仿真中的关系拓扑示意图。 图5为本发明实施例的领航者和跟随者在仿真中的编队过程轨迹示意图。 图6为本发明实施例的领航者和跟随者在仿真中的编队误差收敛示意图。 图7为本发明实施例的领航者和跟随者在仿真中的相对高度倒数估计示意图。 图8为本发明实施例的机器人R2在仿真中的归一化图像误差 收敛过程示意图。 图9为本发明实施例的机器人R2在仿真中的归一化图像误差 收敛过程示意图。 图10为本发明实施例的机器人R3在仿真中的归一化图像误差 收敛过程示意图。 图11为本发明实施例的机器人R3在仿真中的归一化图像误差 收敛过程示意图。 图12为本发明实施例的机器人R4在仿真中的归一化图像误差 收敛过程示意图。 图13为本发明实施例的机器人R4在仿真中的归一化图像误差 收敛过程示意图。 图14为本发明实施例的机器人R5在仿真中的归一化图像误差 收敛过程示意图。 图15为本发明实施例的机器人R5在仿真中的归一化图像误差 收敛过程示意图。