技术摘要:

本发明提供一种基于深度神经网络加速的快速块分割编码方法和装置,在至少一种网络裁剪策略中选出一种网络裁剪策略,通过设置不同的权重参数的保留比例,得到不同复杂度的提前终止机制分层深度卷积神经网络模型;对不同的编码树单元中的编码单元分割采用不同复杂度的提 全部

背景技术:

与上一代视频编码标准H.264相比,高效率视频编码能够有效降低视频码率,但编 码复杂度也成倍增加。在高效率视频编码中,一种灵活的编码树单元分块结构占用大量的 编码复杂度,这是因为其中的率-失真优化过程需要递归的遍历搜索。近年来,研究者们提 出了多种方法,通过深度神经网络直接决定编码树单元中的编码单元分割,跳过费时的遍 历搜索,来降低高效率视频编码的编码复杂度。然而,已有的方法仍然难以进行实时高效率 视频编码,这是因为网络结构本身比较复杂,需要较长的计算时间。

技术实现要素:

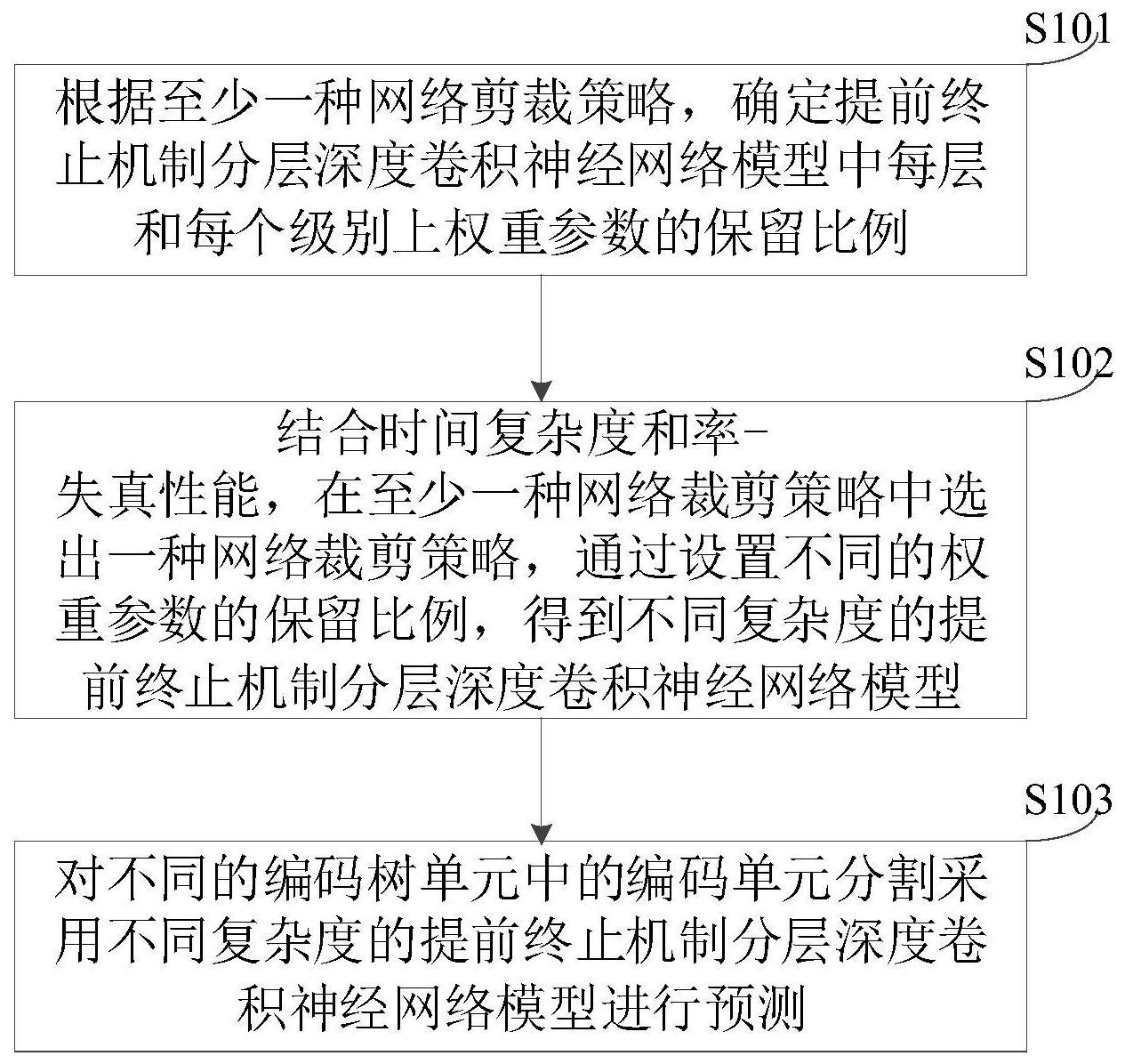

为了解决现有技术存在的至少一个问题,本发明实施例提供了一种基于深度神经 网络加速的快速块分割编码方法和装置。 第一方面,本发明的至少一个实施例提供了一种基于深度神经网络加速的快速块 分割编码方法,包括: 根据至少一种网络剪裁策略,确定提前终止机制分层深度卷积神经网络模型中每 层和每个级别上权重参数的保留比例; 结合时间复杂度和率-失真性能,在至少一种网络裁剪策略中选出一种网络裁剪 策略,通过设置不同的权重参数的保留比例,得到不同复杂度的提前终止机制分层深度卷 积神经网络模型; 对不同的编码树单元中的编码单元分割采用不同复杂度的提前终止机制分层深 度卷积神经网络模型进行预测。 在一些实施例中,上述方法中对不同的编码树单元中的编码单元分割采用不同复 杂度的提前终止机制分层深度卷积神经网络模型进行预测,包括:使得提前终止机制分层 深度卷积神经网络模型的复杂度接近目标复杂度。 在一些实施例中,上述方法中根据至少一种网络剪裁策略,确定提前终止机制分 层深度卷积神经网络模型中每层和每个级别上权重参数的保留比例,包括以下三种策略: 恒定权重参数保留比例; 级间自适应权重参数保留比例; 级间和层间自适应权重参数保留比例。 在一些实施例中,上述方法中对不同的编码树单元中的编码单元分割采用不同复 杂度的提前终止机制分层深度卷积神经网络模型进行预测,包括: 当编码树单元输入提前终止机制分层深度卷积神经网络模型时,进行预处理得到 预处理后的数据; 4 CN 111556316 A 说 明 书 2/7 页 对预处理后的数据经过至少一个卷积层操作后提取纹理特征;所述预处理与卷积 层操作均在并行的支路中进行; 卷积层操作完成后,将并行的支路的特征图伸直,连接成一个特征向量; 将特征向量再次在并行的支路中进行处理后,通过全连接层提取抽象特征,经至 少一个全连接层处理后得到分层编码单元分割图;预处理包括:降采样和去均值。 在一些实施例中,上述方法中将量化参数值作为一个外部特征,添加到至少一个 全连接层中; 在一些实施例中,上述方法中,当编码树单元输入终止机制分层深度卷积神经网 络模型时, 对于帧内模式,提前终止机制分层深度卷积神经网络模型的输入是原始帧中的一 个亮度编码树单元; 对于帧间模式,提前终止机制分层深度卷积神经网络模型的输入是从快速预编码 过程生成的残差帧中的亮度编码树单元。 第二方面,本发明实施例提供了一种基于深度神经网络加速的快速块分割编码装 置,包括: 确定模块:用于根据至少一种网络剪裁策略,确定提前终止机制分层深度卷积神 经网络模型中每层和每个级别上权重参数的保留比例; 设置模块:用于结合时间复杂度和率-失真性能,在至少一种网络裁剪策略中选出 一种网络裁剪策略,通过设置不同的权重参数的保留比例,得到不同复杂度的提前终止机 制分层深度卷积神经网络模型; 预测模块:用于对不同的编码树单元中的编码单元分割采用不同复杂度的提前终 止机制分层深度卷积神经网络模型进行预测。 在一些实施例中,上述装置中的预测模块,用于对不同的编码树单元中的编码单 元分割采用不同复杂度的提前终止机制分层深度卷积神经网络模型进行预测,包括: 使得提前终止机制分层深度卷积神经网络模型的复杂度接近目标复杂度。 在一些实施例中,上述装置中的设置模块根据至少一种网络剪裁策略,确定提前 终止机制分层深度卷积神经网络模型中每层和每个级别上权重参数的保留比例,包括以下 三种策略: 恒定权重参数保留比例; 级间自适应权重参数保留比例; 级间和层间自适应权重参数保留比例。 在一些实施例中,上述装置中对不同的编码树单元中的编码单元分割采用不同复 杂度的提前终止机制分层深度卷积神经网络模型进行预测,包括: 当编码树单元输入提前终止机制分层深度卷积神经网络模型时,进行预处理得到 预处理后的数据; 对所述预处理后的数据经过至少一个卷积层操作后提取纹理特征;所述预处理与 卷积层操作均在并行的支路中进行; 所述卷积层操作完成后,将并行的支路的特征图伸直,连接成一个特征向量; 将所述特征向量再次在并行的支路中进行处理后,通过全连接层提取抽象特征, 5 CN 111556316 A 说 明 书 3/7 页 经至少一个全连接层处理后得到分层编码单元分割图。 本发明实施例的优点在于:根据至少一种网络剪裁策略,确定提前终止机制分层 深度卷积神经网络模型中每层和每个级别上权重参数的保留比例;结合时间复杂度和率- 失真性能,在至少一种网络裁剪策略中选出一种网络裁剪策略,通过设置不同的权重参数 的保留比例,得到不同复杂度的提前终止机制分层深度卷积神经网络模型;对不同的编码 树单元中的编码单元分割采用不同复杂度的提前终止机制分层深度卷积神经网络模型进 行预测,本申请实施例通过提前终止机制分层深度卷积神经网络模型各部分的计算复杂 度,使其中最耗时的部分,即可训练层中的权重参数可以得到显著加速,并且通过联合优化 时间复杂度和率-失真性能,提出一种最优的提前终止机制分层深度卷积神经网络模型裁 剪方法,并由此获得多种不同的提前终止机制分层深度卷积神经网络加速模型,用于预测 编码树单元CTU划分。 附图说明 为了更清楚地说明本发明实施例的技术方案,下面将对实施例或现有技术描述中 所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实 施例,对于本领域普通技术人员来讲,还可以根据这些附图获得其他的附图。 图1为本发明实施例提出的一种基于深度神经网络加速的快速块分割编码方法的 流程示意图之一; 图2为本发明实施例提出的一种基于深度神经网络加速的快速块分割编码装置的 结构示意图。