技术摘要:

本发明涉及一种基于多2D视觉的零部件高精度三维位姿估计方法及系统。其中的方法包括单个2D视觉采集装置工件位姿估计和多视觉采集装置优势参数融合。单个2D视觉采集装置工件位姿估计,主要是将获取的工件图像进行处理获取初步特征点作为精提取输入;并对特征点进行亚像 全部

背景技术:

随着自动化技术的发展和工业制造的升级,越来越多的行业使用机器人(或机械 臂)协助或者替代人类完成作业。在机器人分拣、码放、包装与装配等领域,视觉引导机器人 作业变得越来越重要。在高精度高速要求的精密制造场景,3D视觉由于计算量大、精度不够 等原因,尚未有成熟的应用。而传统的2D视觉因结构简单、精度高、计算量小、成本适中、算 法研究广泛等优点,利用其进行位姿估计在已知可控环境下已经得到广泛应用。成为近年 来位姿估计的研究热点。 对于2D视觉三维位姿估计问题,传统的做法是PnP(Perspective-n-Point)类算 法,该类算法最大的一个缺点是受特征点提取的精度的影响较大,特征点定位精度低位姿 的估计精度会低。目前解决的办法是采用合适的靶标、合适的PnP算法与高精度的特征点提 取方法,来尽可能获得精确的位姿。靶标的设计有许多,主要根据任务的不同分别设计。对 于PnP算法,只要知道n个三维空间点坐标及其对应的二维投影位置时,就可以对位姿进行 估计,在具体的实现过程中根据具体的是否迭代和点的个数其可以分为迭代法与非迭代法 及P3P,P4P,P5P与等于或多于6点的算法。对于特征点提取方法,由于精度需求,在需要提升 到亚像素级别,常用的亚像素定位算法包括插值法,拟合法及矩方法,其中插值法主要分为 二次插值、切比雪夫多项式插值与B样条插值法;矩方法包括:空间矩、灰度矩、Zernike矩等 方法。但是对于基于2D视觉的三维位姿估计都存在一个问题,就是对于空间的点,2D相机的 深度方法的估计能力都是偏差的,求解效果不佳,导致三维姿态的估计存在一定问题。因此 需要采用多相机融合的方法解决该问题。 针对2D视觉的方法存在的问题,如何做到可以应用与机器人抓取和装配精度的位 姿估计,也成为当前机器视觉领域的研究热点。

技术实现要素:

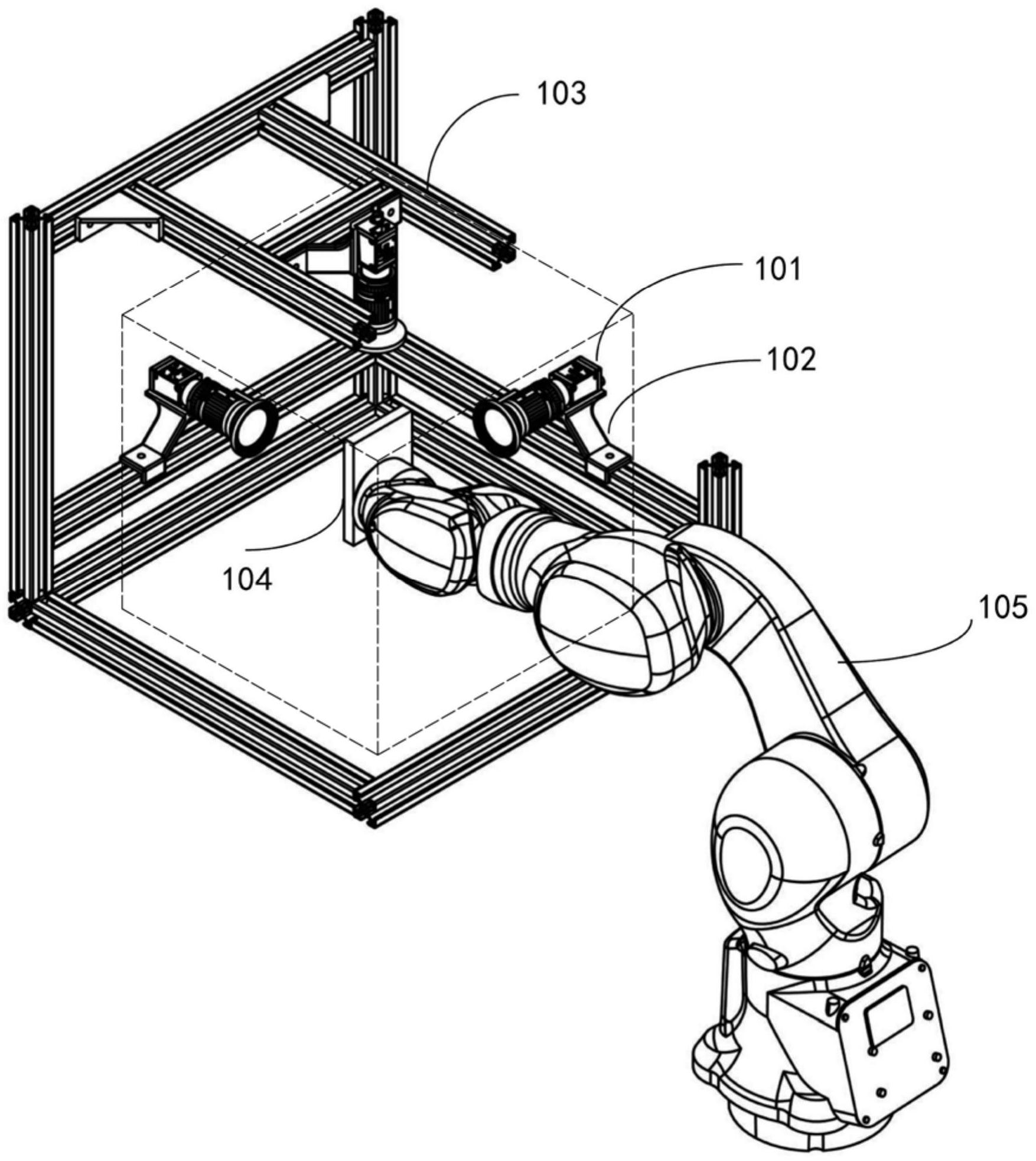

本发明提供一种基于多2D视觉的零部件高精度三维位姿估计方法及系统,旨在至 少解决现有技术中存在的技术问题之一。 本发明的技术方案一方面涉及一种基于多2D视觉的零部件高精度三维位姿估计 方法,该零部件包含目标工件,其特征在于,所述方法包括以下步骤: S0、对在空间互相垂直布置的多个2D视觉采集装置进行预配置,并标定得到所述 的多个2D视觉采集装置的相互位置关系; S1、通过每个2D视觉采集装置获取含有目标工件的场景图像,选用矩形分布的同 心圆靶标,并从该场景图像中检测与定位得到与该2D视觉采集装置关联的所设置的特征区 5 CN 111612794 A 说 明 书 2/7 页 域中的目标工件特征点像素的坐标,然后,结合该特征区域的目标工件特征点之间实际相 对的已知空间位置,利用PnP算法解算得到所述的目标工件基于该2D视觉采集装置坐标系 的位姿; S2、在单独利用每个2D视觉采集装置进行基于实际的目标工件位姿估计后,通过 直接坐标系转换的方式将所有2D视觉采集装置关联的位资估算结果统一到同一坐标系下, 使各2D视觉采集装置优势参数融合,以获得目标工件位姿的完整的估算结果。 在一些实施例中,所述步骤S1包括:S10、通过单2D视觉采集装置获取包含目标工 件的场景图像;S11、基于ELSDc算法的特征点检测与粗略定位分割;S12、利用基于Zernike 矩亚像素检测的方法对分割后的特征点边缘进行亚像素细化,得到实际边缘的亚像素坐 标;S13、利用最小二乘椭圆拟合算法,将已得到的亚像素边缘进行拟合,得到拟合后的特征 点中心亚像素坐标;S14、针对透视投影模型下特征点空间真实中心投影与图像中特征点拟 合中心不一致所产生的偏移现象,结合特征点同心圆与已知半径的性质对拟合中心的偏差 进行补偿;S15、根据特征点坐标及物理尺寸,通过PnP算法计算目标工件对应单个2D视觉采 集装置的位姿估计。 在一些实施例中,所述步骤S12包括:对2D视觉采集装置采集的图像进行预处理, 再对处理后的图像进行Canny边缘检测得到初步边缘;再将处理后图像结合计算得到的 Zernike矩模板进行卷积,生成待检测区域的七个Zernike矩;根据角度参数对所生成的 Zernike矩进行校正;根据计算得到的灰度差参数与距离参数判断单位圆内各点是否为边 缘点,然后输出符合条件的边缘点亚像素坐标。 在一些实施例中,对于不同系数Zernike模板,使用M00、M11R、M11I、M20、M31R、 M31I、M40共七个Zernike模板进行运算。 在一些实施例中,所述步骤S14包括: 结合特征点同心圆与已知半径的性质对拟合中心的偏差进行补偿,其中补偿计算 公式为 其中uB、vB为椭圆中心坐标,uC、vC为补偿后的圆心坐标,K1、K2为两个圆的补偿系 数,r1、r2为圆形半径,使得补偿后的圆心坐标用于后续步骤中的位姿解算。 在一些实施例中,所述步骤S0包括:对在空间互相垂直布置的三个2D视觉采集装 置进行预配置,该三个2D视觉采集装置包括第一视觉采集装置、第二视觉采集装置和第三 视觉采集装置;基于重叠视场标定方法对所述的三个2D视觉采集装置都进行标定,获得多 套结果;对各套结果中的两个视觉采集装置标定的直接结果与通过余下的视觉采集装置间 接求得结果求差值并设为误差函数;选择使总体误差函数最小的标定结果作为最终的标定 结果。 在一些实施例中,所述步骤S2包括: 将标定获得的视觉采集装置的外部参数作为输入,将第二视觉采集装置和第三视 觉采集装置的关联的坐标转换到第一视觉采集装置的坐标,其中: 6 CN 111612794 A 说 明 书 3/7 页 通过第一视觉采集装置所估计出的位姿在基准坐标系下为 cam1T cam1result= Tmodel, 通过第二视觉采集装置所估计出的位姿在基准坐标系下为 通过第三视觉采集装置所估计出的位姿在基准坐标系下为 在上式中,cam1T 、cam2T 、cam3model model Tmodel分别为第一视觉采集装置、第二视觉采集装 置、第三视觉采集装置坐标系到目标工件坐标系的变换矩阵,cam1T 、cam1cam2 Tcam3分别为所述 步骤S0中通过标定获得的视觉采集装置之间的变换矩阵, cam1R cam1model、 tmodel分别为第一视觉采集装置坐标系到目标工件坐标系的旋转矩阵 与平移向量; 在第一视觉采集装置对应的基准坐标系中,根据每个视觉采集装置的特性将各视 觉采集装置优势部分拼接,以获得目标工件位姿的完整的估算结果。 本发明的技术方案还涉及一种计算机装置,包括存储器和处理器,所述处理器执 行储存在所述存储器中的计算机程序时实施上述的方法。 本发明的技术方案还涉及一种基于多2D视觉的零部件高精度三维位姿估计系统, 包括:框架;设置在该框架上的在空间互相垂直布置的多个2D视觉采集装置;以及上述的计 算机装置,该计算机装置与所述的多个2D视觉采集装置通信连接。 在一些实施例中,所述的零部件包括3C部件,该3C部件由机械臂带动;所述的多个 2D视觉采集装置为三个视觉采集装置,该视觉采集装置包括摄像头、工业相机或数码相机; 每个视觉采集装置通过支座可滑动装卸在所述框架上,所述的三个视觉采集装置具有重合 的拍摄视场,使得该重合的拍摄视场覆盖由机械臂带动的所述3C部件。优选地,每个2D视觉 采集装置通过支座可调地安装在所述框架上,并且每个2D视觉采集装置分布于一预设的空 间立方体的面心的位置。 本发明的有益效果如下。 实现对机械臂末端的零部件(尤其3C部件)进行三维位姿估计;采用单视觉采集装 置获取高精度优势参数,多视觉采集装置系统的优势估计参数的融合,使三维位姿估计速 度快、精度高。 对特征点选用矩形分布的同心圆靶标,针对2D视觉采集装置进行位姿估计所依赖 的特征点提取精度问题,对选择的同心圆标志点提出ELSDc粗检测-Zernike矩亚像素检测- 最小二乘椭圆拟合的图像处理优化流程,考虑到二维图像在透视投影下产生的中心投影偏 差现象,结合透视投影模型与同心圆性质进行补偿,最终实现特征点的准确提取。 针对2D视觉采集装置在深度位移与水平角度等劣势方面的不足,采用坐标变换来 对多个视觉采集装置的估计结果进行融合。实验表明位姿估计结果的平移误差在0.2mm内, 旋转误差在0.3°内,耗时不超过2s,可实现对3C部件高精度三维位姿估计的预期目标。 7 CN 111612794 A 说 明 书 4/7 页 附图说明 图1为实施例中根据本发明方法的总体流程简图。 图2为单个2D视觉采集装置进行工件位姿估计的流程图。 图3为基于多个2D视觉采集装置的工件位姿估计结果进行位姿估计结果整合的流 程图。 图4为基于ELSDc算法获得特征点检测与粗略定位分割的标志物。 图5为亚像素定位后的特征轮廓图像。 图6为最小二乘拟合的结果图像。 图7为实施例中根据本发明的基于多2D视觉采集装置的零部件三维位姿估计系统 的立体图。