技术摘要:

本发明提供的基于深度强化学习的机器人行走控制方法,设置奖励机制;构建多专家神经网络;所述多专家神经网络包括一个顶层网络和至少一个底层网络;利用所述奖励机制和采集的样本数据对顶层网络进行训练;在机器人运行过程中,顶层网络根据训练结果和机器人实时测量到 全部

背景技术:

常见的机器人运动控制方法大多数都需要花费大量的人力与时间建造精确的模 型。随着深度强化学习等其他机器学习算法理论的不断完善,以及电脑运算量的不断增加, 机器人运动控制方法中深度强化学习已经成为传统控制算法的替代品。这样深度强化学习 算法就能将大量负担转移到了计算机计算中,比起传统控制方法,节省了人力与时间成本, 解放了大量劳动力。 但是现有采用深度强化学习的机器人运动控制方法中,强化学习的结果很难把 控,可能会学出一些人们意想不到的非理想行为。以双足与四足机器人行走为例,人类与动 物的运动步态是周期性并且对称的。但是在缺乏约束的情况下,采用机器学习方法学出来 的运动步态往往是非对称并且非自然的。

技术实现要素:

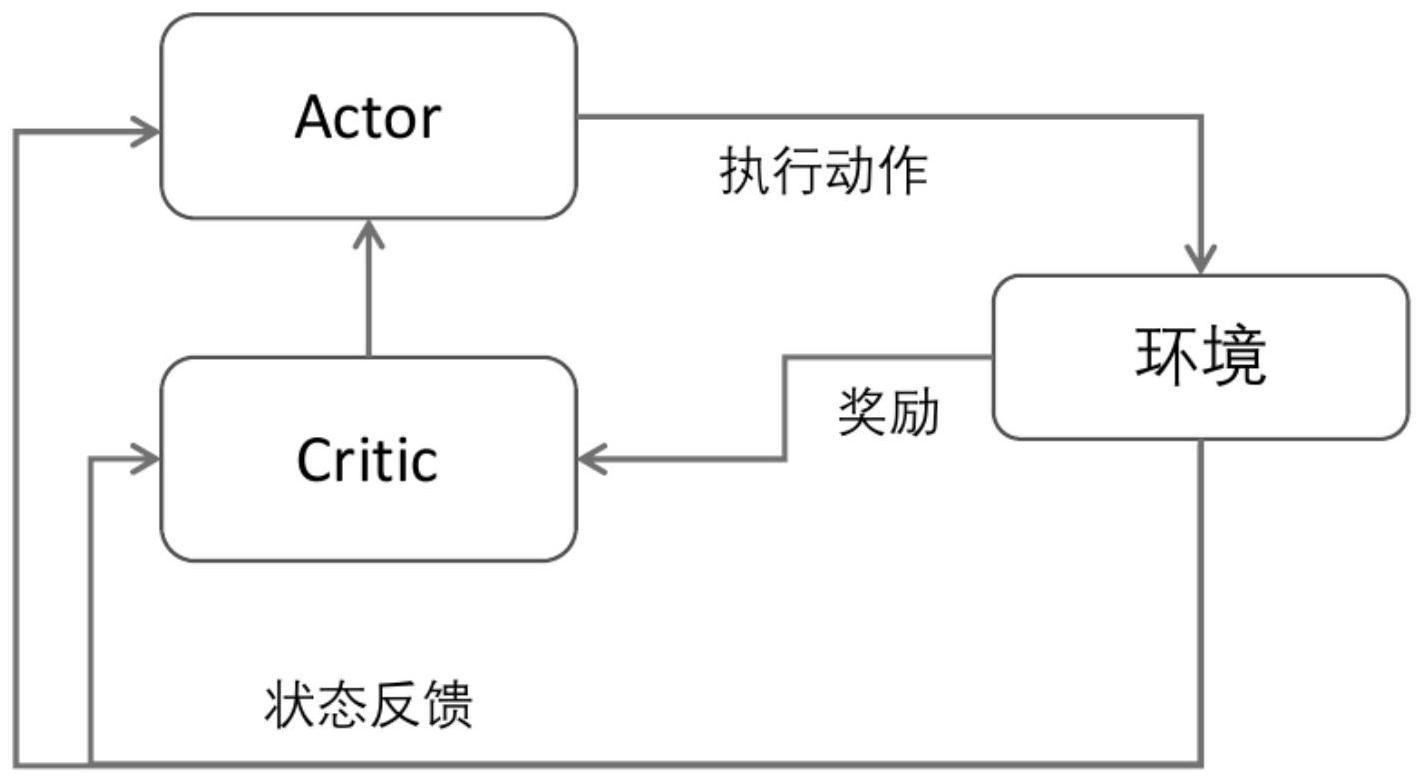

针对现有技术中的缺陷,本发明提供一种基于深度强化学习的机器人行走控制方 法、系统及介质,改善现有机器人运动步态非对称、非自然的缺陷。 一种基于深度强化学习的机器人行走控制方法,包括以下步骤: 设置奖励机制; 构建多专家神经网络;所述多专家神经网络包括一个顶层网络和至少一个底层网 络; 利用所述奖励机制和采集的样本数据对顶层网络进行训练; 在机器人运行过程中,顶层网络根据训练结果和机器人实时测量到的数据对底层 网络的输出进行融合,并根据融合结果输出控制指令,将所述控制指令发送给机器人中关 节的电机。 优选地,所述奖励机制包括模仿奖励和任务奖励; 模仿奖励用于引导机器人学习并模仿人类行走步态;任务奖励用于引导机器人以 指定速度朝着指定方向行走。 优选地,所述模仿奖励中的奖励项包括以下一个或多个的组合: 关节角度、关节角速度和足部接触信息; 所述任务奖励中的奖励项包括以下一个或多个的组合: 胸部俯仰角、胸部滚转角、跨部俯仰角、跨部滚转角、跨部高度、跨部侧向偏移速 度、跨部前向速度、跨部垂直速度、跨部偏航角速度、存活离散奖励、关节力矩。 优选地,所述底层网络由该底层网络中第一层到第三层神经元的权重和偏置构 建; 4 CN 111580385 A 说 明 书 2/9 页 所述顶层网络由该顶层网络中第一层到第三层神经元的权重和偏置构建。 优选地,采集到的样本数据通过以下方法进行过滤: 当通过样本数据检测到机器人摔倒时,删除该样本数据。 优选地,所述对顶层网络进行训练具体包括: 采用具有actor-critic架构的强化学习算法对所述顶层网络进行训练。 优选地,所述将所述控制指令发送给机器人中关节的电机具体包括: 利用PD控制器将所述控制指令转换为目标力矩; 将所述目标力矩发送给机器人中关节的电机。 第二方面,一种基于深度强化学习的机器人行走控制系统,包括处理器和存储器, 所述处理器和存储器相互连接,其中,所述存储器用于存储计算机程序,所述计算机程序包 括程序指令,所述处理器被配置用于调用所述程序指令,执行以下方法: 设置奖励机制; 构建多专家神经网络;所述多专家神经网络包括一个顶层网络和至少一个底层网 络; 利用所述奖励机制和采集的样本数据对顶层网络进行训练; 在机器人运行过程中,顶层网络根据训练结果和机器人实时测量到的数据对底层 网络的输出进行融合,并根据融合结果输出控制指令,将所述控制指令发送给机器人中关 节的电机。 优选地,所述处理器被配置用于调用所述程序指令,具体执行以下方法: 利用PD控制器将所述控制指令转换为目标力矩; 将所述目标力矩发送给机器人中关节的电机。 第三方面,一种计算机可读存储介质,所述计算机存储介质存储有计算机程序,所 述计算机程序包括程序指令,所述程序指令当被处理器执行时使所述处理器执行以下方 法: 设置奖励机制; 构建多专家神经网络;所述多专家神经网络包括一个顶层网络和至少一个底层网 络; 利用所述奖励机制和采集的样本数据对顶层网络进行训练; 在机器人运行过程中,顶层网络根据训练结果和机器人实时测量到的数据对底层 网络的输出进行融合,并根据融合结果输出控制指令,将所述控制指令发送给机器人中关 节的电机。 由上述技术方案可知,本发明提供的基于深度强化学习的机器人行走控制方法、 系统及介质,相对于传统多专家神经网络的离散切换方法,可以在不同的专家网络之间进 行连续切换,增加了组合的多样性,改善现有机器人运动步态非对称、非自然的缺陷。该方 法将人类动作捕捉获得的行走步态作为训练学习的参考对象,能让多专家神经网络更快地 收敛到像人一样自然的周期性对称行走策略。 附图说明 为了更清楚地说明本发明