技术摘要:

本发明公开了一种基于演化计算的联邦学习方法、装置、中心服务器及可读存储介质,所述方法包括:获取各个参与方组的超参数,把超参数发送给所述各个参与方组的每一个参与方,以供各个参与方组中的参与方之间进行联邦学习,而后获取各个参与方组进行联邦学习训练得到的 全部

背景技术:

在联邦学习中,往往使用到诸如神经网络等复杂的模型。此类模型有大量的超参 数,如学习率,网络层数,每层卷积核维度等,现有的联邦学习只能在设定好的固定的超参 数上训练神经网络。由于人为设定的固定的超参数往往不是最优的超参数,因此在人为给 定的超参数下训练的联邦学习模型往往不能达到最好的效果。为了得到好的联邦学习模 型,需要不断人为凭经验调整超参数,并重新进行联邦学习。整个过程费时费力,成本高昂, 且最终模型的性能指标难以保证。 上述内容仅用于辅助理解本发明的技术方案,并不代表承认上述内容是现有技 术。

技术实现要素:

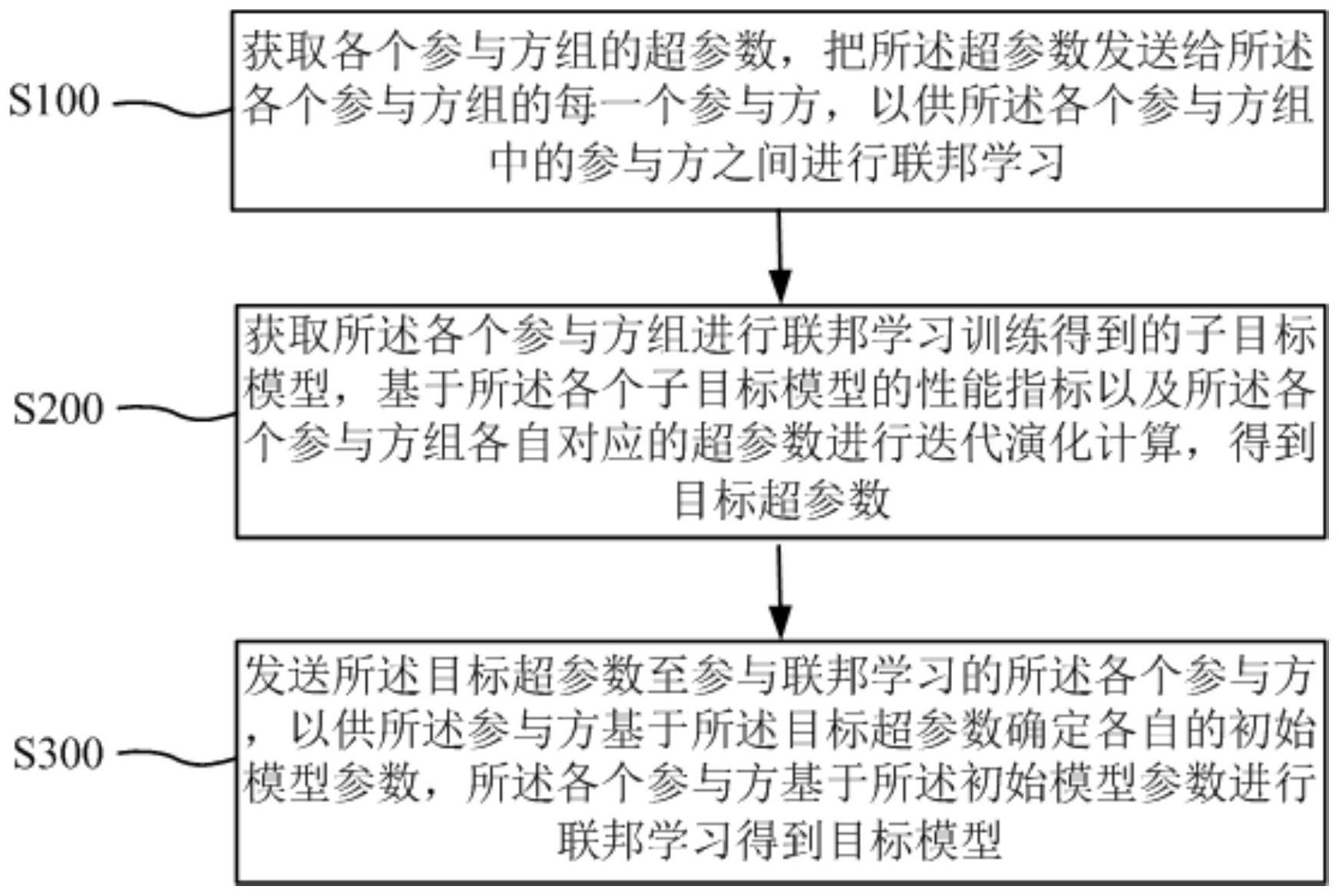

本发明的主要目的在于提供一种基于演化计算的联邦学习方法、装置、中心服务 器及可读存储介质,旨在解决现有的联邦学习中优化超参数效率较低,影响联邦学习模型 性能的技术问题。 为实现上述目的,本发明提供一种基于演化计算的联邦学习方法,应用于中心服 务器,所述的基于演化计算的联邦学习方法包括以下步骤: 获取各个参与方组的超参数,把所述超参数发送给所述各个参与方组的每一个参 与方,以供所述各个参与方组中的参与方之间进行联邦学习; 获取所述各个参与方组进行联邦学习训练得到的子目标模型,基于所述各个子目 标模型的性能指标以及所述各个参与方组各自对应的超参数进行迭代演化计算,得到目标 超参数; 发送所述目标超参数至参与联邦学习的所述各个参与方,以供所述参与方基于所 述目标超参数确定各自的初始模型参数,所述各个参与方基于所述初始模型参数进行联邦 学习得到目标模型。 进一步地,所述基于所述各个子目标模型的性能指标以及所述各个参与方组各自 对应的超参数进行迭代演化计算,得到目标超参数的步骤包括: 确定所述各个子目标模型的性能指标,并根据所述各个子目标模型的性能指标对 各个参与方组各自对应的超参数进行排序,在排序后的各个超参数中得到中间超参数,并 基于所述中间超参数优化各个参与方组各自对应的超参数; 基于优化后的各个参与方组各自对应的超参数进行迭代演化计算,直到检测到迭 代停止条件,得到所述目标超参数。 进一步地,所述基于所述中间超参数优化各个参与方组各自对应的超参数的步骤 4 CN 111723948 A 说 明 书 2/9 页 包括: 基于所述中间超参数确定扩充超参数; 基于所述中间超参数以及所述扩充超参数,优化各个参与方组各自对应的超参 数。 进一步地,所述基于所述中间超参数确定扩充超参数的步骤包括: 在所述中间超参数中选取第一待转换超参数,以对所述待转换超参数的预设位置 的数值进行更新,获得所述扩充超参数;和/或, 在所述中间超参数中选取第二待转换超参数和第三待转换超参数,将所述第二待 转换超参数与所述第三待转换超参数进行数值交换,以获得所述扩充超参数。 进一步地,所述基于所述中间超参数以及所述扩充超参数,优化各个参与方组各 自对应的超参数的步骤包括: 获取随机超参数,并将所述中间超参数、所述扩充超参数以及所述随机超参数替 换各个参与方组各自对应的超参数,得到更新后的各个参与方组各自对应的超参数; 所述获取各个参与方组的超参数,把所述超参数发送给所述各个参与方组的每一 个参与方的步骤包括: 将更新后的各个参与方组各自对应的超参数,分别发送给所述各个参与方组的每 一个参与方。 进一步地,所述直到检测到迭代停止条件,得到目标超参数的步骤包括: 当检测到迭代停止条件时,基于当前各个子目标模型的性能指标,在各个参与方 组各自对应的超参数中确定所述目标超参数。 进一步地,本发明提供一种基于演化计算的联邦学习方法,应用于参与方,所述的 基于演化计算的联邦学习方法包括: 接收中心服务器发送的目标超参数,所述参与方与参与联邦学习的其他各个参与 方基于所述目标超参数确定各自的初始模型参数,并基于各自的所述初始模型参数进行联 邦学习,得到目标模型; 发送所述目标模型至所述中心服务器。 进一步地,所述基于演化计算的联邦学习装置包括: 联邦学习模块,用于获取各个参与方组的超参数,把所述超参数发送给所述各个 参与方组的每一个参与方,以供所述各个参与方组中的参与方之间进行联邦学习; 迭代演化计算模块,用于获取所述各个参与方组进行联邦学习训练得到的子目标 模型,基于所述各个子目标模型的性能指标以及所述各个参与方组各自对应的超参数进行 迭代演化计算,得到目标超参数; 发送模块,用于发送所述目标超参数至参与联邦学习的所述各个参与方,以供所 述参与方基于所述目标超参数确定各自的初始模型参数,所述各个参与方基于所述初始模 型参数进行联邦学习得到目标模型。 进一步地,所述基于演化计算的联邦学习装置包括: 接收模块,用于接收中心服务器发送的目标超参数,所述参与方与参与联邦学习 的其他各个参与方基于所述目标超参数确定各自的初始模型参数,并基于所述各个初始模 型参数进行联邦学习,得到目标模型; 5 CN 111723948 A 说 明 书 3/9 页 传递模块,用于发送所述目标模型至所述中心服务器。 此外,为实现上述目的,本发明还提供一种设备,所述设备包括:存储器、处理器及 存储在所述存储器上并可在所述处理器上运行的基于演化计算的联邦学习程序,所述基于 演化计算的联邦学习程序被所述处理器执行时实现上述任一项所述的基于演化计算的联 邦学习方法的步骤。 此外,为实现上述目的,本发明还提供一种可读存储介质,所述可读存储介质上存 储有基于演化计算的联邦学习程序,所述基于演化计算的联邦学习程序被处理器执行时实 现上述任一项所述的基于演化计算的联邦学习方法的步骤。 本发明获取各个参与方组的超参数,把所述超参数发送给所述各个参与方组的每 一个参与方,以供所述各个参与方组中的参与方之间进行联邦学习,而后获取所述各个参 与方组进行联邦学习训练得到的子目标模型,基于所述各个子目标模型的性能指标以及所 述各个参与方组各自对应的超参数进行迭代演化计算,得到目标超参数,接下来发送所述 目标超参数至参与联邦学习的所述各个参与方,以供所述参与方基于所述目标超参数确定 各自的初始模型参数,所述各个参与方基于所述初始模型参数进行联邦学习得到目标模 型。通过演化计算实现在联邦学习优化模型参数的基础上,同步优化联邦学习的模型超参 数,从而避免人为手动调整超参数,在提升联邦学习中超参数优化效率的同时,显著提升了 联邦学习模型的性能。 附图说明 图1是本发明实施例方案涉及的硬件运行环境中中心服务器的结构示意图; 图2为本发明基于演化计算的联邦学习方法第一实施例的流程示意图; 图3为本发明基于演化计算的联邦学习方法一实施例中基于演化计算的联邦学习 的流程示意图; 图4为本发明基于演化计算的联邦学习装置实施例的功能模块示意图。 本发明目的的实现、功能特点及优点将结合实施例,参照附图做进一步说明。