技术摘要:

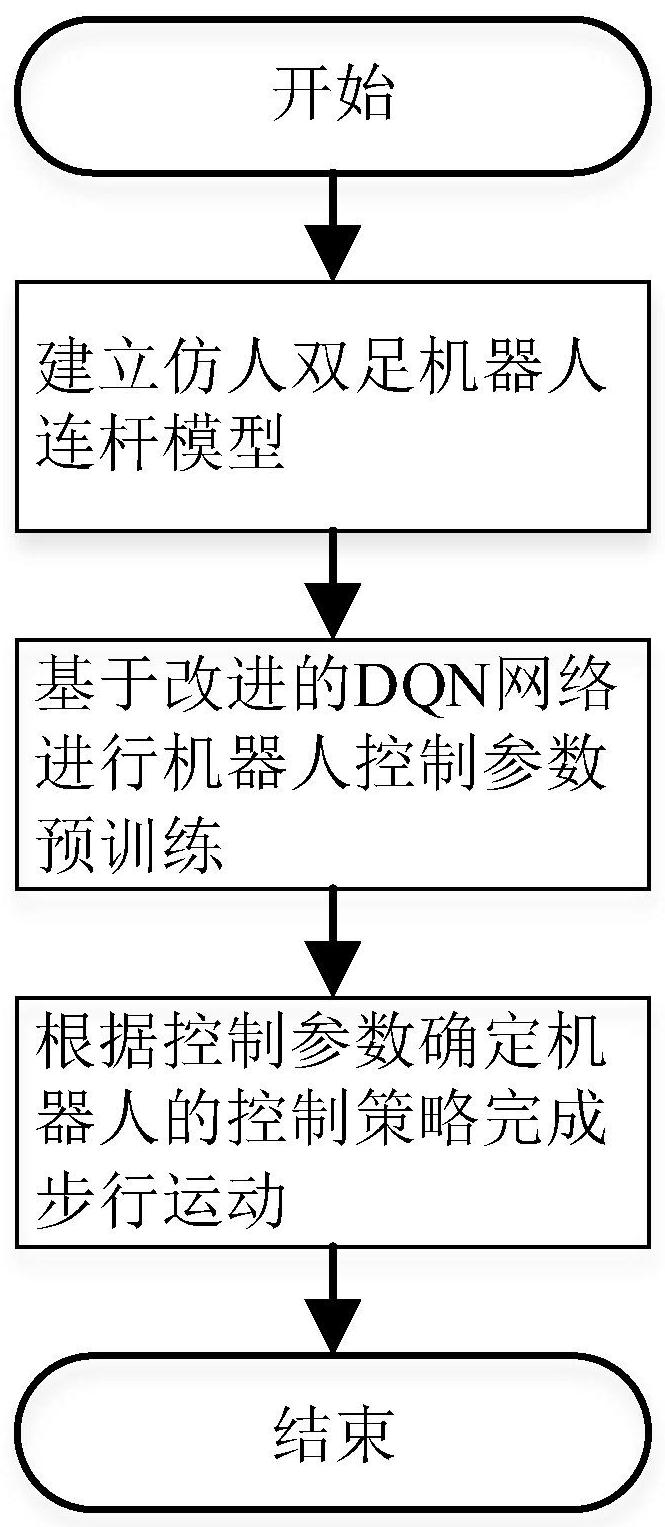

本发明涉及一种机器人技术的改进,具体为一种仿人机器人步态规划的深度强化学习新方法,利用改进的DQN算法解决双足机器人的步行控制问题,在无需建立复杂的双足机器人动力学模型的基础上,将强化深度学习方法用于双足机器人实现在快步行走条件下的长距离稳定步态控制, 全部

背景技术:

仿人双足机器人具有类人型的结构能够适应诸如楼梯、街道、非平整地面等复杂 地形环境,具有运动形式灵活的特点。因此,该类型运动形式的机器人可以用于医疗、救援、 服务、探索等诸多行业领域。人类运动看起来很简单,却是一个涉及多个自由度的非常复杂 的动作。它可以看作是通过下半身的伸肌和屈肌群把这些自由度相互关联而产生的复杂非 线性动力学,这也成为正确理解运动研究中涉及的生理学并将其复制到双足机器人的动 机。双足步行机器人具有便捷性、灵活性,可穿越大范围的地形,因此其运动稳定性至关重 要。然而,由于非线性和不稳定因素使得其运动姿态的控制系统设计困难。面对双足步行系 统的稳定性问题,近些年许多学者使用传统的控制体系结构做了大量相关工作。这些传统 的控制理论方法依赖于复杂数学工程模型以及确定性问题。最近,相关学者的研究表明机 器学习比传统的控制方法在双足行走稳定性上更具优势。 仿人双足步行控制可以看作是解决未经处理的高维感官输入中的复杂任务。近年 来,深度学习在解决高维复杂问题上已有很多成果。其中DQN算法能够解决高维观测空间的 问题,但它只能处理离散和低维的动作空间。一般来说,使用大型非线性函数逼近器来学习 价值函数既困难又不稳定。结合DQN算法的优点,使用重播缓冲区中的样本对网络进行非策 略训练,以最大程度地减少样本之间的相关性,再利用目标网络训练以在时间差备份期间 给出一致的目标,给出一种使用深度函数逼近器的无模型、偏离策略的操作、评论算法DDPG (Deep Deterministic Policy Gradient)。该算法作为学习高维、连续动作空间中的策略 的无模型方法可以使用相同的低维观测值(例如笛卡尔坐标或关节角)来学习所有任务的 竞争策略超参数和网络结构。在许多情况下,它还可以直接从像素中学习良好的策略,从而 再次保持超参数和网络结构不变。操作-评论的算法会根据近似评论的价值估算来更新策 略。由于DDPG算法使用确定性策略梯度作为更新策略,而该更新会导致价值估计中的过高 估计。尽管每次更新时这种高估可能都是最小的,但是估计误差的出现会引起误差叠加以 及策略更新不佳。故本文提出一种双Q学习修正函数取代评论函数得到一种改进的DQN算 法,以此解决该问题。

技术实现要素:

本发明要解决的技术问题克服现有的缺陷,提供一种仿人机器人步态规划的深度 强化学习新方法,利用改进的DQN算法解决双足机器人的步行控制问题,在无需建立复杂的 双足机器人动力学模型的基础上,将强化深度学习方法用于双足机器人实现在快步行走条 件下的长距离稳定步态控制。 为了解决上述技术问题,本发明提供了如下的技术方案:一种仿人机器人步态规 4 CN 111546349 A 说 明 书 2/7 页 划的深度强化学习新方法,包括建立仿人双足机器人模型、预训练控制参数和双足机器人 步行运动; 其中,仿人双足机器人模型采用简化的6自由度连杆模型,足部采用平面足底结 构; 预训练控制参数采用改进的DQN网络结构的深度强化学习进行控制器的训练; 双足机器人步行运动是指通过训练的控制器实现稳定性。 作为优选,所述预训练控制参数具体是指:首先,利用三维建模建立双足机器人模 型并导入到仿真平台预训练基于改进DQN的深度强化学习网络。 在此过程中采用经验回放机制和目标Q值网络,来确保基于改进DQN的深度强化学 习网络在训练过程中收敛;采用策略梯度算法,实现在连续的动作空间根据所学习到的策 略随机筛选动作;再针对策略梯度算法不让其随机选择,只输出一个动作值。 作为优选,对于策略随机筛选,Σπ(a|s)=1策略输出的是动作的概率,使用正态 分布对动作进行采样选择,即每个动作都有概率可能选到。 作为优选,只输出一个动作值,具体是指确定性策略,π(s)S→A策略输出即是动 作。 作为优选,DDPG算法使用确定性策略梯度作为更新策略,并在减少高估偏差提本 新的修正算法,在操作-评论算法中优化评论部分,结合针对DDPG网络结构改进后的总体网 络结构。 作为优选,基于改进的DQN算法的深度强化学习仿人机器人步态规划的新方法具 体步骤如下:预训练控制参数采用改进的DQN网络结构的深度强化学习具体包括如下步骤: 步骤1:利用三维建模软件绘制,训练前将该模型导入到Matlab内,包括腰部,大 腿、小腿及双足,连杆的尺寸的单位为m;腰部、大腿、小腿选用泡沫塑料,密度为0.5g/cm3, 足部选用工程塑料,密度为1.0g/cm3,并保证整个双足机器人的重心保持在腰部的中心,并 建立6个关节,即髋关节、膝关节和踝关节作为旋转关节,各种关节变量的作用范围分别为 [-pi/4,pi/4],[0.1,pi],[-pi/4,pi/4];在模型建立后,确定接触刚度、阻尼、静摩擦和动 摩擦作为仿真参数; 步骤2:使用改进的DQN算法进行智能体训练,具体包含以下关键步骤: 步骤2.1:操作与评论函数;估计策略和价值函数,智能体维护4个函数近似器: 操作μ(s):操作进行观察s并输出相应的动作,以最大化长期奖励; 目标操作μ′(s):智能体会根据最新的操作参数值定期更新目标操作; 双Q值评论Q(s,a):评论将观察值s和操作a分别作为输入和对长期奖励相应期望 的输出; 双目标评论Q′(s,a):智能体会根据最新的评论参数值定时更新目标评论; Q(s,a)和Q′(s,a)二者具有相同的结构和参数化,并且μ(s)和μ′(s)二者具有相同 的结构和参数化,训练完成后,将训练好的最佳策略存储在操作μ(s)中; 步骤2.2:智能体创建:创建智能体具体操作步骤包括: a)创建一个操作表示对象; b)创建评论表示对象; c)指定智能体选项; 5 CN 111546349 A 说 明 书 3/7 页 d)函数创建智能体; 步骤3:创建智能体后,可进行智能体训练;该智能体使用以下训练算法,在每个时 间步长更新操作和评论模型; 用随机参数值θQ初始化评论Q(s,a),并使用相同的随机参数值θQ′=θQ初始化目标 评论; 用随机参数值θμ初始化操作μ(s),并用相同的参数值θμ′=θμ初始化目标操作; 对于每个训练时间步长: 1.对于当前观测值s,选择操作a=μ(s) n,其中n是来自噪声模型的随机噪声; 2.执行动作a,观察奖励r和下一个观察s′; 3.将经验(s,a,r,s′)存储在经验缓冲区中; 4.从经验缓冲区中随机抽取M个小批量的经验(si,ai,ri,s′i); 5.如果s′i是终端状态,则将价值函数目标yi设置为r,否则将其设置为: 其中,γ为折扣系数,价值函数目标是经验奖励ri和评论网络对应未来奖励折扣 的最小值二者之和,智能体首先通过将下一个观察结果s′i从采样的经验传递到目标操作 来计算下一个动作;然后,智能体添加噪声ε到已经计算的动作,并且将动作以噪声的上下 限进行分割;智能体通过将下一个动作传递给目标评论来找到累积奖励; 6.通过最小化所有采样经验中的损失L更新评论参数; 7.使用以下样本策略梯度更新操作参数,以最大化预期权值奖励; 其中 其中a=μ(si|θμ),Gai为最小评论输出对应由操作网络计算动作的梯度,而Gμi是操 作输出对应操作参数的梯度,两个梯度均由观测值si估计; 9.根据目标更新方法更新目标操作和评论;智能体使用目标平滑化,并在每个时 间步长更新目标操作和评论; 步骤4:根据控制参数确定机器人的控制策略进行步态的控制,利用Matlab进行仿 真;仿真结果在10s内连续向前行走到终点,选取其中的一次稳定控制仿真实验,具体是指 双足机器人在整个步行任务中并未出现跌倒的情况发生且保持姿态稳定,各关节的力矩在 (-3,3)N·m范围内周期变化。 作为优选,智能体使用目标平滑化,并在每个时间步长更新目标操作和评论具体 是指:在每一个时间步长均会利用平滑因子t更新目标,对应的评论和操作参数分别为 θμ′=tθμ (1-t)θμ′。 本发明有益效果:本发明的将深度强化学习引入仿人双足机器人步态控制,利用 改进的DQN方法进行训练,能够尽可能地确保训练的网络快速收敛,同时可以增强仿人双足 机器人控制器的稳定性和鲁棒性。对于机器人所处环境的变化,只需要重新进行学习即可 适应巨大差异化的环境变化。 6 CN 111546349 A 说 明 书 4/7 页 附图说明 图1为仿人双足机器人步态控制结构框图; 图2为双足机器人连杆模型; 图3为改进DQN算法的网络结构框图; 图4为双足机器人步态控制的运动关键帧; 图5双足机器人关节力矩曲线。