技术摘要:

本发明属于目标检测与机器人操作领域,公开了基于异构深度网络融合的动态目标抓取姿态快速检测方法。所述方法包括:1.动态目标样本集的制作方法;2.异构深度网络的训练方法;3.异构深度网络的融合机制;4.抓取姿态确定方法。待检测的动态目标物体,通过深度相机获取其R 全部

背景技术:

视觉环境下的动态目标抓取操作是智能机器人领域非常具有挑战性的一个研究 方向。其中,动态目标的抓取姿态检测是最为关键和核心的内容。抓取姿态主要包括目标物 体的三维空间坐标和对应的抓取边界,针对的是常用的二指或三指机械手。 视觉条件下的抓取姿态检测主要包括四个步骤:(1)特征提取,(2)目标识别,(3) 抓取姿态识别,(4)抓取姿态确定。当前的主流方法都是遵循先进行目标识别,然后将目标 区域进行图像分割,从而继续进行抓取姿态识别与确定。例如,对于目标识别可采用视觉特 征描述子或高精度动态相机,抓取姿态一般采用几何分析等。然而,基于特征描述子的方法 对光照、环境、物体的纹理特征等具有较多限制,适应性较差,检测精度和实时性均很难满 足实际的工业需求;抓取姿态的几何分析方法耗时较长,实时性较差,也容易受物体形状影 响。同时,高精度的测量仪器往往价格昂贵,对使用环境较为苛刻,难以大范围应用。此外, 不同于静态目标抓取,动态目标对抓取姿态的检测精度、实时性和安全性都有较高的要求, 尤其是当测量误差较大或实时性较差时,容易导致设备损坏、财产损失等安全事故,这无疑 增加了检测的难度。随着深度神经网络在机器视觉领域的快速发展,越来越多的研究人员 开始使用深度神经网络来提取特征信息进行目标识别,或实现抓取姿态识别。但这些基于 深度神经网络的方法在具体应用上较为单一化,很难充分发挥不同神经网络在识别领域的 优点,难以实现快速准确的抓取姿态检测。

技术实现要素:

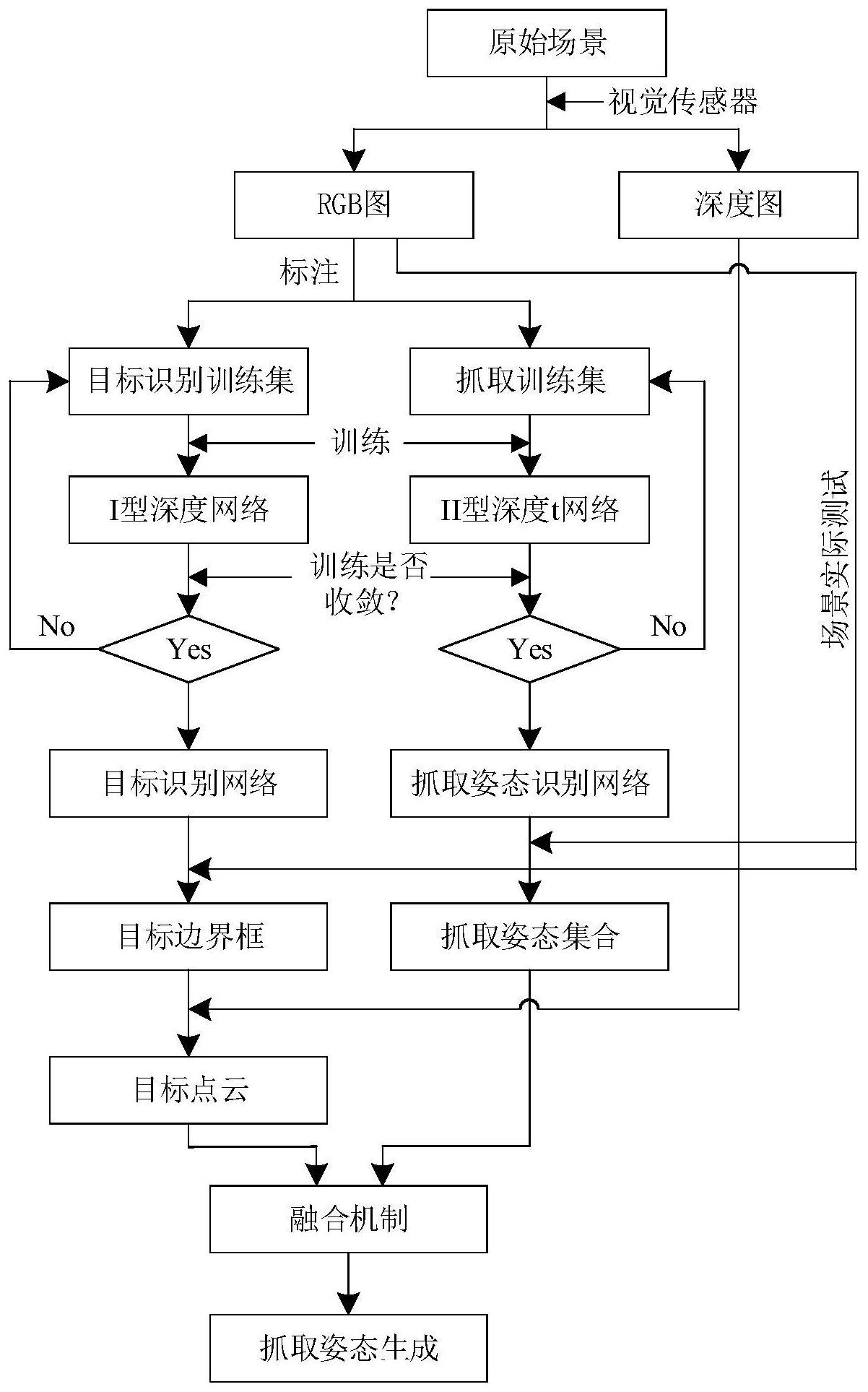

本发明目的是提供一种基于异构深度网络融合的动态目标抓取姿态检测方法,通 过不同结构类型的融合,充分发挥不同类型神经网络的特色与优点,进而为动态目标抓取 姿态的确定提供快速、准确和高鲁棒性的检测结果,作为后续机器人实现自主操作的基础。 本发明提供一种基于异构深度网络融合的动态目标抓取姿态快速检测方法,包括 以下步骤: S1:通过视觉传感器获取目标场景的RGB图像和深度图像; S2:对所获得的RGB图像进行目标物体标注和抓取边界标注,分别作为目标训练集 T1和抓取姿态训练数据集T2; S3:将训练集T1输入I型深度网络,进行迭代训练,当loss函数低于0.5,则训练结 束,作为目标识别网络;将训练集T2输入II型深度网络进行迭代训练,当loss函数低于0.1, 则训练结束,作为抓取姿态识别网络; S4:在实际测试中,通过视觉传感器连续获取实际场景的RGB图和深度图,将RGB图 输入步骤S3获得的目标识别网络,获取目标边界框平面坐标[(p1 ,q1) ,(p2 ,q1) ,(p1 ,q2) , 4 CN 111598172 A 说 明 书 2/5 页 (p2,q1)];同时,将RGB图输入步骤S3获得的抓取姿态识别网络,获取抓取边界坐标集合Tg; 其中,第i个抓取边界为[(mi1,ni1) ,(mi2,ni2) ,(mi3,ni3) ,(mi4,ni4)]; S5:根据目标边界平面坐标,利用如下公式计算目标的中心点平面坐标(p0,q0); S6:根据目标的中心点平面坐标(p0,q0),遍历查找对应的深度图,结合机器人视觉 系统的坐标转换关系,从而获取目标中心点的点云坐标(x0,y0,z0),作为目标物体在世界坐 标系中的三维坐标; S7:抓取边界坐标集合Tg,计算所有抓取边界的中心位置集合Cg,其中第i个抓取边 界中心点坐标为(ci1,ci2); S8:根据目标的中心点平面坐标(p0,q0),遍历查找抓取边界的中心位置集合Cg,寻 找与目标中心点平面坐标(p0,q0),最近的抓取边界的中心位置;设符合条件的是第i*个抓 取边界中心坐标,对应的抓取边界为[(mi*1,ni*1) ,(mi*2,ni*2) ,(mi*3,ni3) ,(mi*4,ni*4)];通过 机器人视觉系统的坐标转换关系,得到符合条件的抓取边界对应的世界坐标为[(Mi*1 , Ni*1) ,(Mi*2,Ni*2) ,(Mi*3,Ni*3) ,(Mi*4,Ni*4)]; S9:根据符合条件的第i*个抓取边界的世界坐标,利用如下公式计算获取抓取边 界对应的一个方向向量为d=[1,k]; 对应的单位方向向量为e=[e1,e2],其计算方式如下: S10:根据目标物体的点云坐标和抓取边界的单位向量,得到目标物体对应的抓取 姿态[x0,y0,z0,e1,e2]。 进一步地,上述步骤S3所述的I型深度网络为YOLOV3网络、SSD网络、YOLOV4网络、 Faster RCNN网络、Mask RCNN网络、RetinaNet网络、DSSD网络中的一种。 进一步地,上述步骤S3所述的II型深度网络为ResNet网络、DenseNet网络、DPN网 络、SE-Net网络、AOGNet网络中的一种。 本发明的有益效果是同时采用不同类型的深度网络,通过融合机制来实现动态目 标抓取姿态获取的方法,打破了传统方法只能利用单一深度网络进行目标识别或抓取姿态 识别的局限,通过异构网络融合完成抓取姿态检测。通过这种异构网络的融合机制,既可以 进行快速的目标识别与定位,又能完成高精度的抓取姿态检测,同时满足实时性和实用性 5 CN 111598172 A 说 明 书 3/5 页 的要求,该方法具有较大的发展前景。 附图说明 图1为目标物体的标注示意图。 图2为抓取姿态的标注示意图。 图3为实施例1的基于I型深度网络的目标识别示意图。 图4为实施例1的基于II型深度网络的抓取姿态识别示意图。 图5为动态目标抓取姿态检测方法流程图。 图中:1目标物体1;2目标物体2;3目标物体3;4目标物体4;5目标物体5;6目标物体 6。