技术摘要:

一种用于控制节点网络的系统和方法。该方法包括:估计由一对节点之间存在或不存在直接连接所引起的对目标的影响;以及至少部分地基于对影响的估计来改变节点网络的结构。节点网络包括严格偏序集、加权有向无环图、人工神经网络和/或分层前馈神经网络。

背景技术:

三十多年来,人工神经网络代表了机器学习方面的领先技术之一。在过去的十年 中,深度神经网络(即具有多层的网络)已经远远超过了其先前的性能,并导致了人工智能 方面的许多显著改进。所公认的是,能够训练具有更多层网络的能力是这种性能方面显著 提高最重要的因素之一。 然而,神经网络中存在的层越多,训练起来就越困难。在过去的五十年中,这一事 实一直是神经网络在每一点上性能的主要限制,直到今天仍然如此。训练高而瘦的网络(即 具有多层且每层只有相对较少的节点的网络)尤其困难。此类高而瘦的网络是所期望的,因 为与较短、较宽的网络相比,它们在较少参数的情况下具有更大的表示能力。因此,它们可 以学习更复杂的功能,而更少倾向于过度拟合训练数据。 即使具有适度层数的神经网络也需要非常大量的计算来进行训练。用于训练神经 网络的标准算法是迭代随机梯度下降,其基于:对网络中每个节点的激活进行前馈计算,之 后通过链式法则计算对梯度的估计,该链式法则是通过针对每个训练数据项向后通过神经 网络而对偏导数进行反向传播来实现,同时针对每个小批量数据项迭代更新学习的参数。 通常,整个批量的训练数据含有多个小批量。对训练集中的所有小批量执行迭代更新一轮 称为一纪元。在这种迭代训练过程中的一个重要问题是,存在出现平台期的趋势,即其中学 习非常缓慢的训练间隔,偶尔伴有非常快速学习的短暂周期。在许多情况下,在这些相对无 效的缓慢学习周期期间耗费绝大多数的时间和计算。 此外,随机梯度下降仅利用固定的指定体系结构来更新神经网络的参数。其无法 改变该体系结构。

技术实现要素:

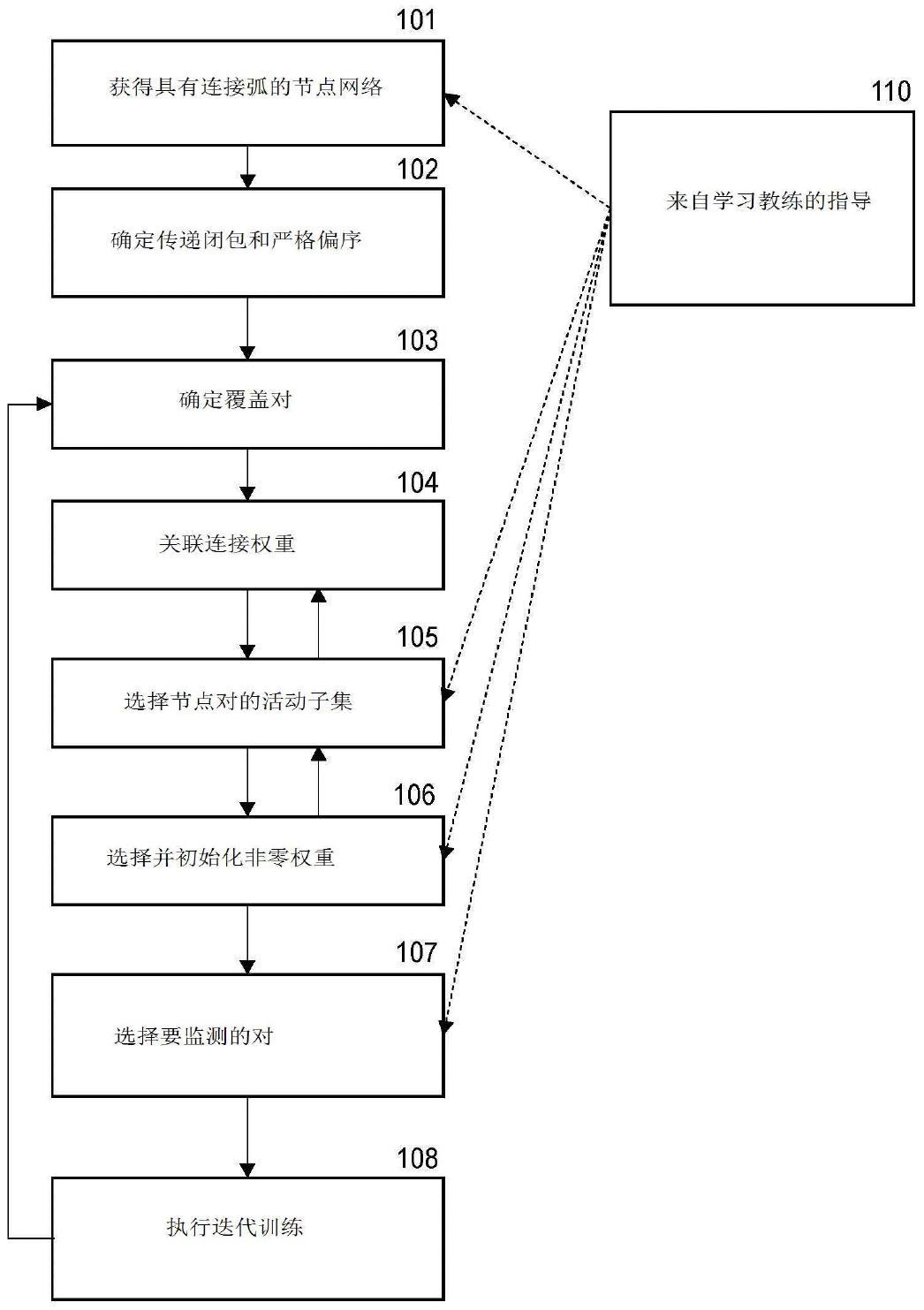

在一个总体方面,本发明涉及用于控制包含一对节点的节点网络的计算机实现的 系统和方法。节点包含激活函数,其可以根据由目标函数定义的目标在数据集上进行评估。 该方法包含:(a)估计由该对节点之间存在或不存在直接连接所引起的对目标的影响;以及 (b)至少部分地基于对影响的估计来改变节点网络的结构。改变节点网络的结构可以包括 在节点之间添加新的直接连接或删除节点之间预先存在的直接连接。节点网络包括严格偏 序集、加权有向无环图、人工神经网络和/或分层前馈神经网络。 在另一个总体方面,本发明涉及以以下方式重组第一神经网络以生成第二神经网 13 CN 111602149 A 说 明 书 2/45 页 络的计算机实现的系统和方法,即该方式使得相比于第一神经网络的性能,重组不会降低 性能。第一神经网络可以包含多个节点,多个节点包含节点A和B,其中第一网络中的多个节 点通过多个弧互连。该方法包含以下步骤中的至少一个:(a)按照由所述多个弧确定的有向 图的传递闭包所定义的严格偏序,添加从节点A到节点B的弧,除非B小于A;或者(b)删除节 点A和B之间的弧。 在另一个总体方面,本发明涉及重组第一神经网络以生成第二神经网络的另外其 他计算机实现的系统和方法。其他方法包含以下步骤中的至少一个:(a)将新节点添加到第 一网络;或者(b)删除第一网络中的第一预先存在的节点,其中来自第一预先存在的节点的 所有弧的权重为零。在这样的实施例中,添加新节点包含:(i)将从新节点到第一网络中预 先存在的节点的所有弧初始化为权重为零;以及(ii)通过梯度下降更新来自新节点的所有 弧的权重。 下文描述了其他发明和创新实施方式。通过下面的描述将显而易见的是,本申请 的发明解决了上述问题和其他问题。 附图说明 在本文中通过示例并结合附图对本发明的各种实施例进行描述。 图1是训练具有严格偏序的自组织节点集的整个过程的流程图。 图2是迭代训练程序的流程图。 图3是显示其他图中所引入的程序和能力之间的关系的组织图。 图4是用于在缓慢学习间隔期间加速学习的一个程序的流程图。 图5是用于在缓慢学习间隔期间加速学习的第二程序的流程图。 图6是图5所示的学习加速程序的第二实施例的流程图。 图7是用于在缓慢学习间隔期间加速学习的第三程序的流程图。 图8是用于合并两个或更多个自组织偏序网络的过程的流程图。 图9是用于改变自组织网络以允许在与当前偏序相反的方向上进行连接的过程的 流程图。 图10是用于使自组织偏序网络发展为能够模仿将违反原始网络中偏序的新连接 的过程的流程图。 图11是用于减少机器学习系统中的过度拟合的过程的流程图。 图12是用于减少机器学习系统中的过度拟合的过程的第二变型的流程图。 图13是用于将机器学习系统的集成合并到自组织网络中的过程的流程图。 图14是用于在自组织偏序网络中创建各种专用节点集的过程的流程图。 图15是在本发明的一些实施例中使用的分析和训练过程的流程图。 图16是用于训练机器学习系统的子系统以学习互补性知识的过程的流程图。 图17是实现自组织训练任意网络(包括递归网络和带周期的有向图)的过程的流 程图。 图18是用于子任务上的多个网络的系统的框图。 图19是用于将有向无环图映射到分层网络表示中的过程的流程图。 图20是扩充分层神经网络的过程的流程图。 14 CN 111602149 A 说 明 书 3/45 页 图21A是布置在两层中的神经网络的图。 图21B是布置在四层中的具有与图21A相同的有向无环图的神经网络的图。 图21C是布置在六层中的具有与图21A相同的有向无环图的神经网络的图。 图22A是神经网络的图。 图22B是图22A的神经网络在两个节点之间的连接反向情况下的图。 图22C是按分层配置布置从图22B所得到的神经网络的图。 图23A是神经网络的图。 图23B是图23A的神经网络经历将线性同伴节点添加到非线性节点的过程的图。 图23C是图23A和图23B的神经网络经历将线性同伴节点添加到非线性节点的过程 的图。 图24是诸如可以在本发明的各种例示性实施例中使用的计算机系统的图。 图25是诸如可以在本发明的各种例示性实施例中使用的深前馈人工神经网络的 图。