技术摘要:

本发明公开了一种带标注的手与物体复杂交互真实彩色数据生成方法及装置,该方法包括:通过使用两台相对放置的RGBD相机采集人手与物体交互过程,获得两组彩色‑深度数据对序列,使用深度数据对交互过程进行重建,获得人手姿态、物体几何和物体姿态,并将其转换到彩色相 全部

背景技术:

人使用手与物体进行交互是日常生活中非常常见的场景,手与物体交互过程包含 了丰富的信息。对人手与物体的交互过程进行重建是计算机视觉的重要研究领域,对于AR/ VR,HCI以及智能机器人等产业都具有非常重要的应用价值。在计算机视觉领域和与视觉相 关的产业中,彩色相机是应用最为广泛的视觉传感器。随着人工智能的发展,使用神经网络 处理单目彩色图片序列对人手与物体交互过程进行重建是目前研究的热点问题也是最有 应用前景的方案。为了训练能够通过处理单目彩色图像序列重建手与物体交互过程的神经 网络,如何获得训练数据成为了最重要的问题。然而,目前少有成熟的,且不破坏视觉信息 的真实彩色数据生成方案。

技术实现要素:

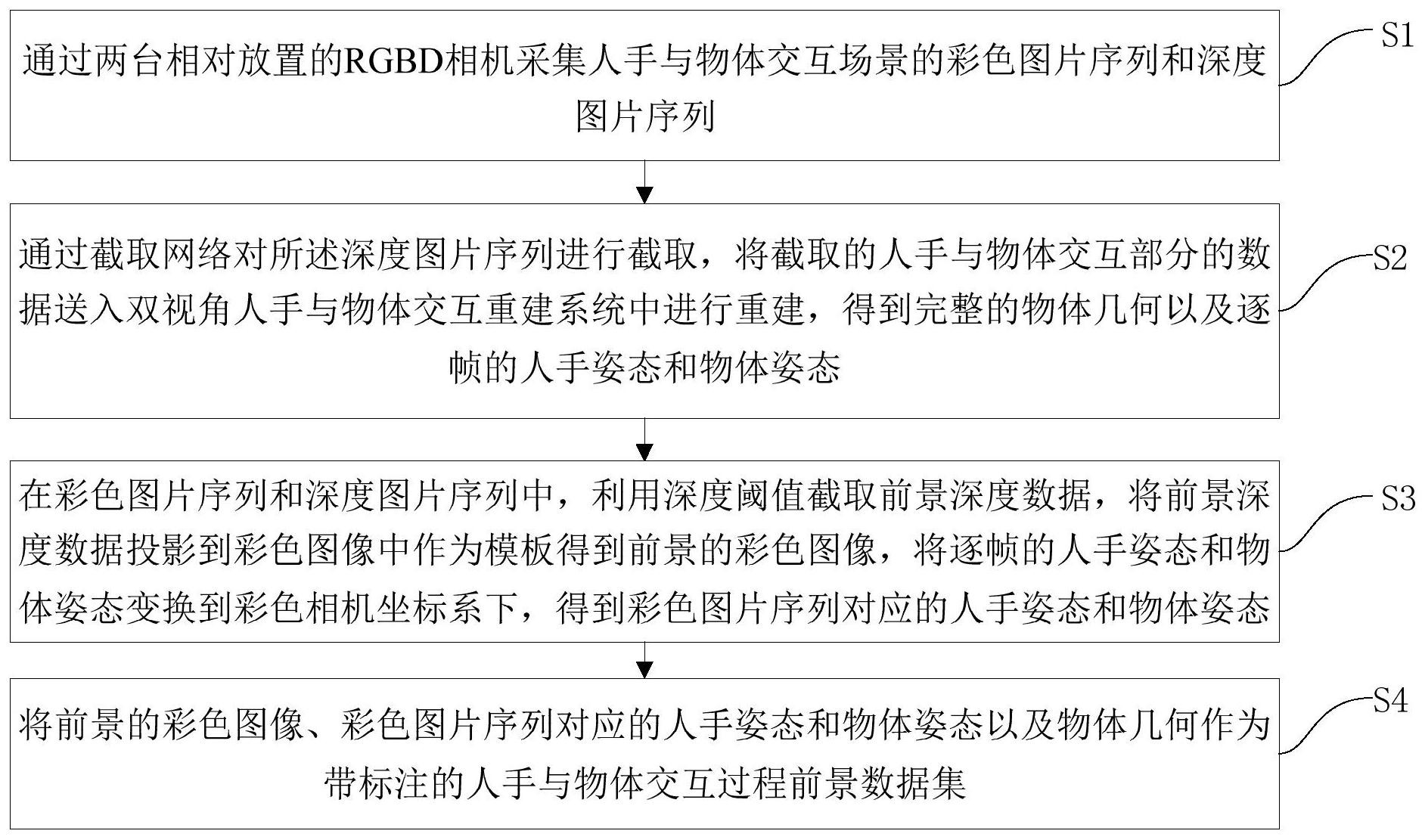

本发明旨在至少在一定程度上解决相关技术中的技术问题之一。 为此,本发明的一个目的在于提出一种带标注的手与物体复杂交互真实彩色数据 生成方法,该方法在深度序列上分割人手与物体交互部分并重建人手姿态、物体几何和姿 态,算法中不需要对彩色数据的特殊要求,不会破坏彩色数据。 本发明的另一个目的在于提出一种带标注的手与物体复杂交互真实彩色数据生 成装置。 为达到上述目的,本发明一方面实施例提出了一种带标注的手与物体复杂交互真 实彩色数据生成方法,包括: S1,通过两台相对放置的RGBD相机采集人手与物体交互场景的彩色图片序列和深 度图片序列; S2,通过截取网络对所述深度图片序列进行截取,将截取的人手与物体交互部分 的数据送入双视角人手与物体交互重建系统中进行重建,得到完整的物体几何以及逐帧的 人手姿态和物体姿态; S3,在所述彩色图片序列和所述深度图片序列中,利用深度阈值截取前景深度数 据,将所述前景深度数据投影到彩色图像中作为模板得到前景的彩色图像,将所述逐帧的 人手姿态和物体姿态变换到彩色相机坐标系下,得到所述彩色图片序列对应的人手姿态和 物体姿态; S4,将所述前景的彩色图像、所述彩色图片序列对应的人手姿态和物体姿态以及 物体几何作为带标注的人手与物体交互过程前景数据集。 本发明实施例的带标注的手与物体复杂交互真实彩色数据生成方法,通过使用两 台相对放置的RGBD相机采集人手与物体交互过程,获得两组彩色(RGB)-深度(D)数据对序 4 CN 111583134 A 说 明 书 2/7 页 列,使用深度数据对交互过程进行重建,获得人手姿态、物体几何和物体姿态,并将其转换 到彩色相机坐标系下,建立单目RGB和人手姿态、物体几何和物体姿态的数据集。为了对数 据进行增强,可采集不同场景的彩色-深度数据作为背景,然后将人体与物体部分作为前景 根据深度融合到不同的背景中,即可得到增强的数据集。由此,在深度序列上分割人手与物 体交互部分并重建人手姿态、物体几何和姿态,算法中不需要对彩色数据的特殊要求,不会 破坏彩色数据。 另外,根据本发明上述实施例的带标注的手与物体复杂交互真实彩色数据生成方 法还可以具有以下附加的技术特征: 在本发明的一个实施例中,在所述S1之前还包括: S0,在人手上佩戴特殊颜色的护腕,通过RGBD相机采集人手与物体交互的彩色-深 度图片序列,通过护腕对人手和物体交互部分的深度图片序列进行截取,构建深度图片序 列上的截取训练数据集进行训练得到截取网络。 在本发明的一个实施例中,所述S0具体包括: S01,使人手佩戴特殊颜色的护腕与物体在RGBD相机前进行交互; S02,使用单台RGBD相机采集交互的彩色图片序列和深度图片序列; S03,利用特殊颜色的护腕的彩色信息截取人手和物体的数据,获得截取框; S04,构建深度图片序列与人手和物体有效信息截取框的数据集; S05,训练输入为交互的深度信息,输出为人手与物体信息截取框的截取网络。 在本发明的一个实施例中,所述将截取的人手与物体交互部分的数据送入双视角 人手与物体交互重建系统中进行重建,包括: 通过两轮求解策略进行重建,在第一轮求解中,初始状态下没有物体几何,物体模 型融合模块开启,通过第一轮求解获得逐帧的人手姿态、物体姿态和所述完整的物体几何; 在第二轮求解中,将第一轮获得的所述完整物体几何作为物体的已知模型,关闭 所述物体模型融合模块,以第一轮得到的逐帧的人手姿态和物体姿态作为初始值,求解交 互的逐帧人手姿态和物体姿态。 在本发明的一个实施例中,在所述S4之后还包括: S5,利用RGBD相机采集不同场景的彩色图片序列和深度图片序列作为背景,将所 述前景的彩色图像与所述不同场景的背景进行深度检测融合,得到具有不同背景的带标注 的人手与物体交互过程的增强数据集。 在本发明的一个实施例中,所述S5具体包括: S51,将背景深度数据中像素值为0的像素赋值为预设值; S52,逐像素比较前景深度图和背景深度图,记录前景深度大于背景深度的像素 数; S53,计算前景深度大于背景深度的像素数与有效前景像素数的比值; S54,在比值小于深度阈值时,将前景的有效彩色数据覆盖到背景彩色数据上,生 成增强数据集。 在本发明的一个实施例中,在所述S1中,将两台RGBD相机采集的彩色图片序列和 深度图片序列进行时间对齐和空间位置标定 为达到上述目的,本发明另一方面实施例提出了一种带标注的手与物体复杂交互 5 CN 111583134 A 说 明 书 3/7 页 真实彩色数据生成装置,包括: 采集模块,用于通过两台相对放置的RGBD相机采集人手与物体交互场景的彩色图 片序列和深度图片序列; 重建模块,用于通过截取网络对所述深度图片序列进行截取,将截取的人手与物 体交互部分的数据送入双视角人手与物体交互重建系统中进行重建,得到完整的物体几何 以及逐帧的人手姿态和物体姿态; 变换模块,用于在所述彩色图片序列和所述深度图片序列中,利用深度阈值截取 前景深度数据,将所述前景深度数据投影到彩色图像中作为模板得到前景的彩色图像,将 所述逐帧的人手姿态和物体姿态变换到彩色相机坐标系下,得到所述彩色图片序列对应的 人手姿态和物体姿态; 生成模块,用于将所述前景的彩色图像、所述彩色图片序列对应的人手姿态和物 体姿态以及物体几何作为带标注的人手与物体交互过程前景数据集。 本发明实施例的带标注的手与物体复杂交互真实彩色数据生成装置,通过使用两 台相对放置的RGBD相机采集人手与物体交互过程,获得两组彩色(RGB)-深度(D)数据对序 列,使用深度数据对交互过程进行重建,获得人手姿态、物体几何和物体姿态,并将其转换 到彩色相机坐标系下,建立单目RGB和人手姿态、物体几何和物体姿态的数据集。为了对数 据进行增强,可采集不同场景的彩色-深度数据作为背景,然后将人体与物体部分作为前景 根据深度融合到不同的背景中,即可得到增强的数据集。由此,在深度序列上分割人手与物 体交互部分并重建人手姿态、物体几何和姿态,算法中不需要对彩色数据的特殊要求,不会 破坏彩色数据。 另外,根据本发明上述实施例的带标注的手与物体复杂交互真实彩色数据生成装 置还可以具有以下附加的技术特征: 在本发明的一个实施例中,还包括:训练模块,用于在人手上佩戴特殊颜色的护 腕,通过RGBD相机采集人手与物体交互的彩色-深度图片序列,通过护腕对人手和物体交互 部分的深度图片序列进行截取,构建深度图片序列上的截取训练数据集进行训练得到截取 网络。 在本发明的一个实施例中,还包括:增强模块,用于利用RGBD相机采集不同场景的 彩色图片序列和深度图片序列作为背景,将所述前景的彩色图像与所述不同场景的背景进 行深度检测融合,得到具有不同背景的带标注的人手与物体交互过程的增强数据集。 本发明附加的方面和优点将在下面的描述中部分给出,部分将从下面的描述中变 得明显,或通过本发明的实践了解到。 附图说明 本发明上述的和/或附加的方面和优点从下面结合附图对实施例的描述中将变得 明显和容易理解,其中: 图1为根据本发明一个实施例的带标注的手与物体复杂交互真实彩色数据生成方 法流程图; 图2为根据本发明一个实施例的截取网络训练流程图; 图3为根据本发明一个实施例的前景彩色图与背景彩色图的深度检测融合流程 6 CN 111583134 A 说 明 书 4/7 页 图; 图4为根据本发明一个实施例的带标注的手与物体复杂交互真实彩色数据生成装 置结构示意图。