技术摘要:

本发明公开了基于深度学习模型和相对方位标定的图片文字识别方法,包括:步骤S100:采用OCR检测模型检测图片中的文字区域,获取文字区域的边界坐标点;步骤S200:切出文字区域,并采用文字识别模型识别文字区域的内容;步骤S300:从识别的内容中获取要提取的字段;步骤 全部

背景技术:

在生活与工作场景中经常需要对各种数码显示屏读取数据进行记录,如医院血透 科室护士需要对血透仪的数码显示屏读取数据并记录到病案的场景,而医院中使用的血透 仪有几十上百台,护士采用手工将数据一一录入需要花费很多时间。现有技术中也有一些 利用OCR识别模型识别图像,但是,识别模型训练集中需要对字符的坐标进行事先标注,操 作繁琐的问题。

技术实现要素:

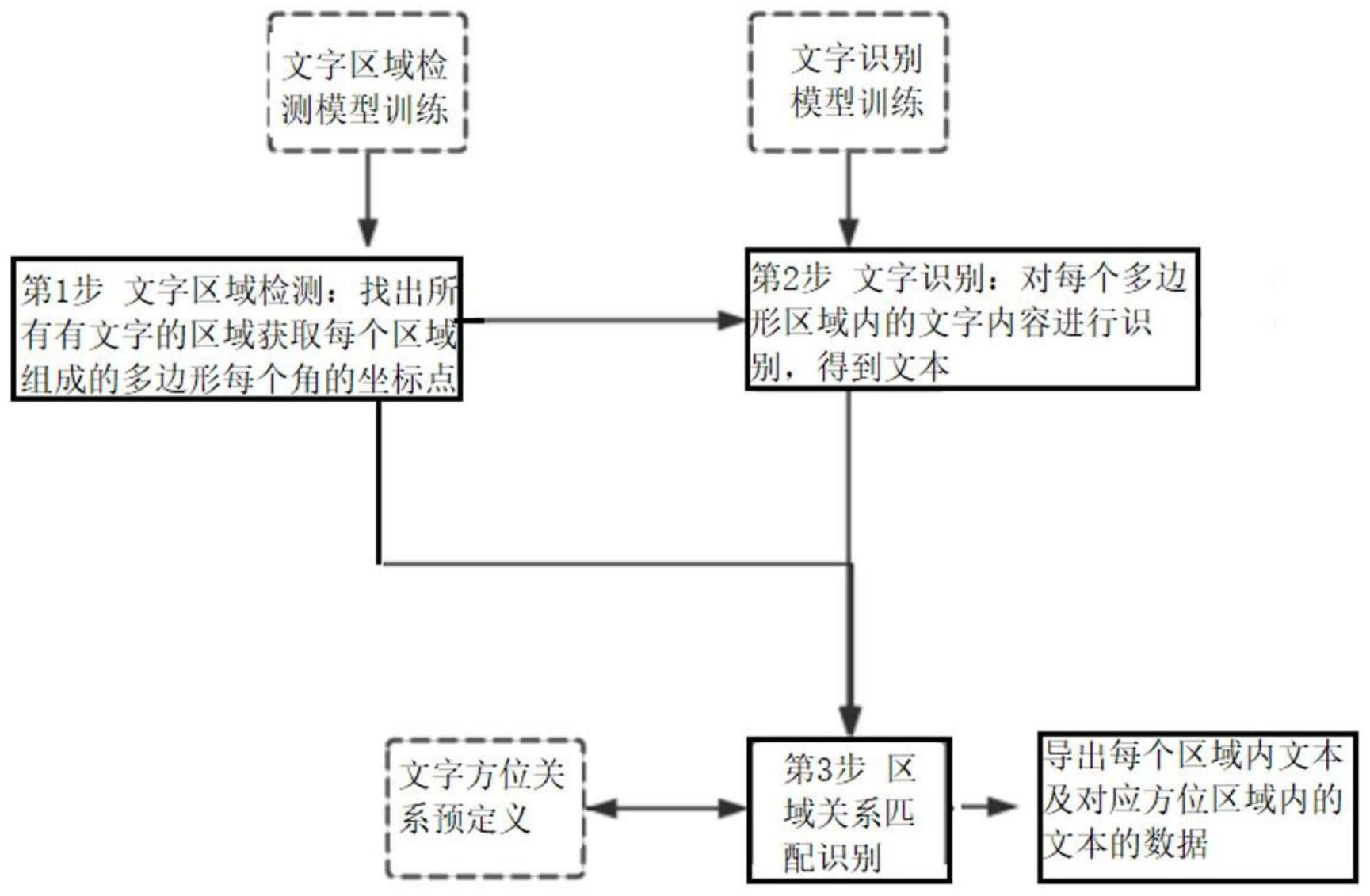

本发明的目的在于提供基于深度学习模型和相对方位标定的图片文字识别方法, 用于解决现有技术中手工录入数据费时以及识别模型需要实现进行坐标标注操作繁琐的 问题。 本发明通过下述技术方案解决上述问题: 基于深度学习模型和相对方位标定的图片文字识别方法,包括: 步骤S100:采用OCR检测模型检测图片中的文字区域,获取文字区域的边界坐标 点; 步骤S200:切出文字区域,并采用文字识别模型识别文字区域的内容; 步骤S300:从识别的内容中获取要提取的字段; 步骤S400:根据事先定义的文字方位关系找到与该字段匹配的提取值。 所述步骤S400中对每一个要提取的字段,分别采用以下方法找到匹配的提取值: A:将字段对应的文字区域的边界延伸,将其相邻区域分成八个方位; B:根据预先定义的文字方位关系,找到位于该字段的预设方位的所有提取值,计 算各个提取值到字段对应的文字区域的中心距离,中心距离最小的提取值即为该字段匹配 的值。 所述计算提取值到文字区域的中心距离的方法为:分别计算各个提取值所在的文 字区域的中心点,再分别计算提取值所在的文字区域的中心点与字段所在文字区域中心点 的距离,得到中心距离。 所述中心点由文字区域的边界坐标点计算得到。 还包括将字段与提取值以及其对应关系导出至表格。 本发明与现有技术相比,具有以下优点及有益效果: (1)本发明仅定义相对方位关系,不定义识别区域绝对位置;适应性极强,在一定 范围内,识别准确度与拍照角度无关,即使图片歪斜,光照强,光照弱,文字扭曲,也能有很 高识别率,不需要对图片位置纠偏。 3 CN 111597956 A 说 明 书 2/5 页 (2)本发明迁移性强,对于一个新的机器信息识别,原始模型可以不用训练,也不 用编写新的代码,只需要配置一个简单的新方位模板,也能有较高的准确率。 (3)模型具有一般性,遇到新的识别场景,只需标注数张或数十张图片,再进行迁 移学习,即可获得很高的准确率,无需修改添加任何代码。 附图说明 图1为本发明的流程图; 图2为待识别的图片; 图3为文字方位关系示意图。