技术摘要:

本发明公开了一种面向基于人工免疫算法对抗攻击的对抗防御方法,包括以下步骤:(1)获取原始图片样本集;以原始图片样本为基础,基于人工免疫算法生成对抗样本;将原始图片样本与对抗样本合并,分为训练集和测试集;(2)利用训练集和测试集对图片分类器进行训练,获得图 全部

背景技术:

最近几年,深度神经网络在很多机器学习领域获得了巨大的突破,例如:图像分 类、目标识别、目标检测、语音识别、语言翻译、语音合成等领域。然而,尽管深度神经网络在 这些领域获得了极大的成功,但是,最近也有大量的研究证明,即便是性能最优秀的深度神 经网络,它依然能被对抗样本攻破。这一发现对一些关键的安全应用程序构成了严重威胁, 例如自动汽车、生物识别和监控系统。可以简单地试想,在一个自动汽车系统中,本来应该 被识别为红灯停的图片因为受到了对抗样本的攻击,被识别成了绿灯通行,那会造成多么 巨大的危害。这一现象也引起了深度学习领域学者们的广泛关注。 对抗样本是由对抗攻击生成,通过精心设计人的肉眼看不到的噪声扰动,再添加 到干净的样本上,可以达到欺骗深度神经网络的效果,即极大地改变深度网络的输出,并且 具有很高的置信度。目前,已经有很多关于对抗攻击的著作和文献。总的来说,对抗攻击可 以大致分为两类:黑盒攻击和白盒攻击。分类的依据则是基于暴露给攻击者的目标模型的 相关信息。例如,在白盒攻击中,攻击者可以得到完整的深度神经网络信息,这其中主要包 含神经网络的架构和内部参数。与之相反,不能直接获取神经网络的相关信息,只能通过传 递给神经网络的输入和与之对应的输出的相关信息来作为攻击的途径,就是黑盒攻击。在 大部分应用领域,例如图像分类、目标检测等,因为白盒攻击可以获得更丰富的信息资料, 所以一般情况下,白盒攻击对比黑盒攻击经常会获得更高的攻击成功率。 目前,针对已有文献中提出的各种对抗攻击,经过大量研究和尝试,有很多的防御 方法被提出,用来设计在面对对抗样本时更鲁棒的深度神经网络模型。现有的对抗防御方 法主要可以分为两类。第一种是监督策略:这些策略旨在通过将被噪声破坏的输入作为训 练样本或将应用不同攻击产生的对抗样本注入到深度神经网络的训练阶段中来提高模型 的泛化程度。这类方法的特点是非常适合于特定的扰动模式,并且只能部分地规避由其他 攻击场景(例如,具有不同的扰动分布)生成的对抗样本。第二类对抗防御方法是无监督策 略:这些策略的目的是通过在损失函数中加入平滑惩罚作为正则化项来平滑决策边界,或 者通过去除不必要的变量来压缩神经网络模型。这些工作是基于一个隐含的假设发展起来 的,即对抗性样本的存在是由在高维度的空间中的决策边界的分段线性行为决定的,这里 的决策边界主要通过梯度下降法得到。因此,如果在输入空间中处考虑稍高的扰动去跨过 平滑的决策边界,那么对抗样本的有效性就会受到影响。 然而,在上述提到的方法中,在面对基于人工免疫算法的对抗攻击时,防御的效果 普遍较差,分类器的识别准确率较低。 4 CN 111598210 A 说 明 书 2/6 页

技术实现要素:

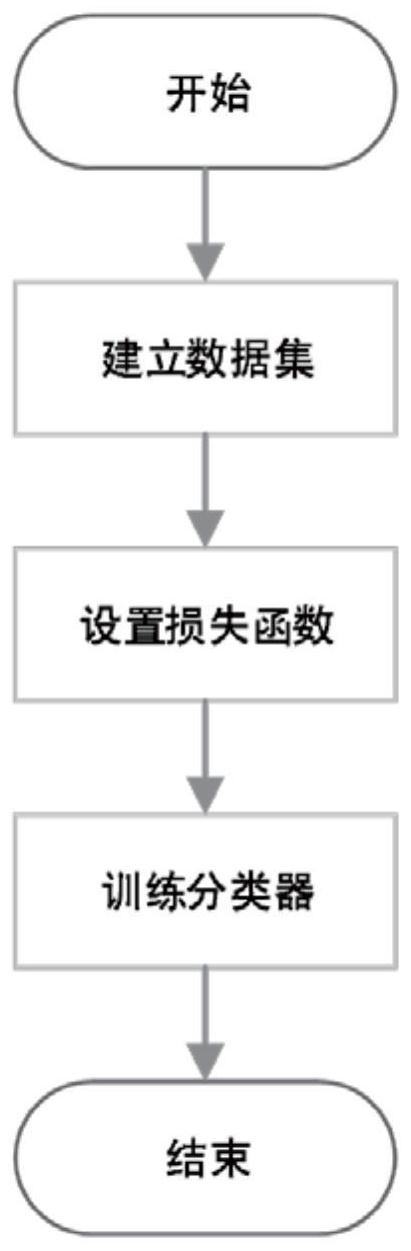

本发明提供了一种面向基于人工免疫算法对抗攻击的对抗防御方法,以解决在面 对基于人工免疫算法对抗攻击时,现有技术的防御效果较差、分类器识别准确率较低的技 术问题。 本发明的具体技术方案如下: 一种面向基于人工免疫算法对抗攻击的对抗防御方法,包括以下步骤: (1)获取原始图片样本集;以原始图片样本为基础,基于人工免疫算法生成对抗样 本;将原始图片样本与对抗样本合并,分为训练集和测试集; (2)利用训练集和测试集对图片分类器进行训练,获得图片识别模型; (3)利用图片识别模型对待识别图片进行识别,实现图片识别的对抗防御。 所述的原始图片样本集为cifar10数据集,包括60000张图片样本。 以原始图片样本为基础,基于人工免疫算法生成对抗样本,包括以下步骤: (i)在每个原始图片样本上随机添加扰动块,构成N个不同的扰动样本,建立初始 种群n0;N为25~50; 以如下公式在原始图片样本上添加扰动块: 式中,x表示原始图片样本横坐标,y表示原始图片样本纵坐标;当mxy等于0时,表明 原始图片样本在该位置处不添加扰动,当mxy等于1时,表明样本在该位置处添加扰动;rand ( )表示在区间[0,1]上服从均匀分布的随机数。 (ii)依据适应度函数计算每个扰动样本的适应度值;依据适应度值成比例地生成 扰动样本的克隆体,再对每个克隆体进行变异操作,生成子样本群n1; 所述的适应度函数为: F=f(x′)y ||x′-x||0 (4) 式中,x′为扰动样本;x为x′对应的原始图片样本;y为x的目标标签;f(x′)y表示图 片分类器将扰动样本x′识别成目标标签y的置信度;||x′-x||0表示x′与x差的0范式,即为 增加的扰动个数。 对每个克隆体进行变异操作如下式所示; x′=x λ·N(0,1)·ef* (5) 式中,x′为扰动样本;x为x′对应的原始图片样本;f*是x的适应度经0~1标准化后 的值,即f*∈[0,1];N(0,1)表示标准正太随机分布数,其中均值μ等于0,标准方差σ等于1;λ 是比例常数,用于控制指数函数的衰减程度。优选的,λ取值为0.1。 (iii)将子样本群n1与初始种群n0合并形成新样本群n01,根据样本的适应度对新 样本群n01中的样本进行帕累托排序,选取N个较优样本形成样本记忆集M; 根据样本的适应度对新样本群n01中的样本进行帕累托排序包括:对新样本群n01 进行非支配排序,对所有样本进行分层;计算每层中样本的拥挤度,对同层中的样本进行排 序;选择N个较优样本形成样本记忆集M。 对新样本群n01进行非支配排序包括: a)计算每个样本的被支配度Np和支配度Sp; 5 CN 111598210 A 说 明 书 3/6 页 支配度Np表示个体p被种群中多少其他样本支配,支配度Sp表示样本p支配种群中 样本的总数量。 b)设置i=0,i表示层级; c)挑出新样本群n01中支配度Np为i的个体,构成非支配样本群Fi; d)遍历Fi中的每一个个体,在该过程中,遍历每个个体的Sp中的个体;当遍历到Sp 中的某个体时,将该个体的Np减1;Fi遍历完成后,将Np为0的个体归入非支配样本群Fi 1; e)i=i 1; f)重复步骤d)~e),直到所有个体完成分级。 样本的拥挤度计算公式如下: Ii=(f1,i 1-f1,i-1)/(f1max-f1min) (f2,i 1-f2,i-1)/(f2max-f2min) (8) 其中,Ii表示第i个样本的拥挤度;f1,i 1表示第i 1个样本的第一个目标函数值; f1max表示该层所有个体中,第一个目标函数能取到的最大值;f2,i 1表示第i 1个样本的第二 个目标函数值;f2max表示该层所有个体中,第二个目标函数能取到的最大值;f1,i-1表示第i- 1个样本的第一个目标函数值;f1min表示该层所有个体中,第一个目标函数的最小值;f2,i-1 表示第i-1个样本的第二个目标函数值;f2min表示该层所有个体中,第二个目标函数的最小 值;第一目标函数为F1=minf(x′)y;第二目标函数为F2=||x′-x||0。 (iv)针对样本记忆集M,计算两样本之间的相似度,若相似度小于网络抑制阈值ζ, 则删除两个样本中的一个; 两样本之间的相似度用两者之间的欧氏距离表示。两样本相距越近,表明它们越 相似。 (v)根据步骤(i)的方法随机生成扰动样本并引入到样本记忆集M中,引入的扰动 样本数目与步骤(iv)中删除的样本数目相同; (vi)重复步骤(ii)~(v),直至迭代次数达到预设值,获得对抗样本集。 优选的,步骤(vi)中,迭代次数的预设值为50。 所述的图片分类器包括依次连接的两层卷积层和两层全连接层;第一层卷积层包 含32个卷积核,卷积核大小为5*5,步长为2,激活函数采用relu函数;第二层卷积层包含64 个卷积核,卷积核大小为5*5,步长为2,激活函数采用relu函数;第一层全连接层包含1024 个神经元,激活函数采用relu函数;第二层全连接层包含10个神经元,激活函数采用 softmax函数。 对所述的图片分类器进行训练时,采用的损失函数为 式中,i表示第i个样本,y为样本的标签,表示样本被识别正确的概率。 对所述的图片分类器进行训练时,学习率设置为0.001;优化算法采用Adadelta方 法;迭代次数设置为20。 与现有技术相比,本发明的有益效果为: 本发明采用人工免疫算法进行多目标优化,人工免疫算法本身具有较强的多样 性,调整性,算法中的克隆和变异操作也都有助于局部优化,这使得生成的对抗样本具有较 强的攻击性能。本发明使用该对抗样本进行对抗训练,使得到的模型面对对抗攻击具有较 6 CN 111598210 A 说 明 书 4/6 页 强的防御效果。 附图说明 图1为本发明的面向基于人工免疫算法的对抗攻击进行对抗防御的方法流程示意 图; 图2为实施例中基于人工免疫算法生成扰动的对抗攻击流程示意图。