技术摘要:

本发明公开了一种基于VGG16网络层级优化的身份证图像分类方法,获取图像数据集VOC2007数据集,进行数据预处理和训练集测试集的划分;构建基于VGG16改进后的卷积神经网络训练模型。利用划分好的训练样本集合进行模型的训练。模型预训练权重调用。本发明通过修改经典分类 全部

背景技术:

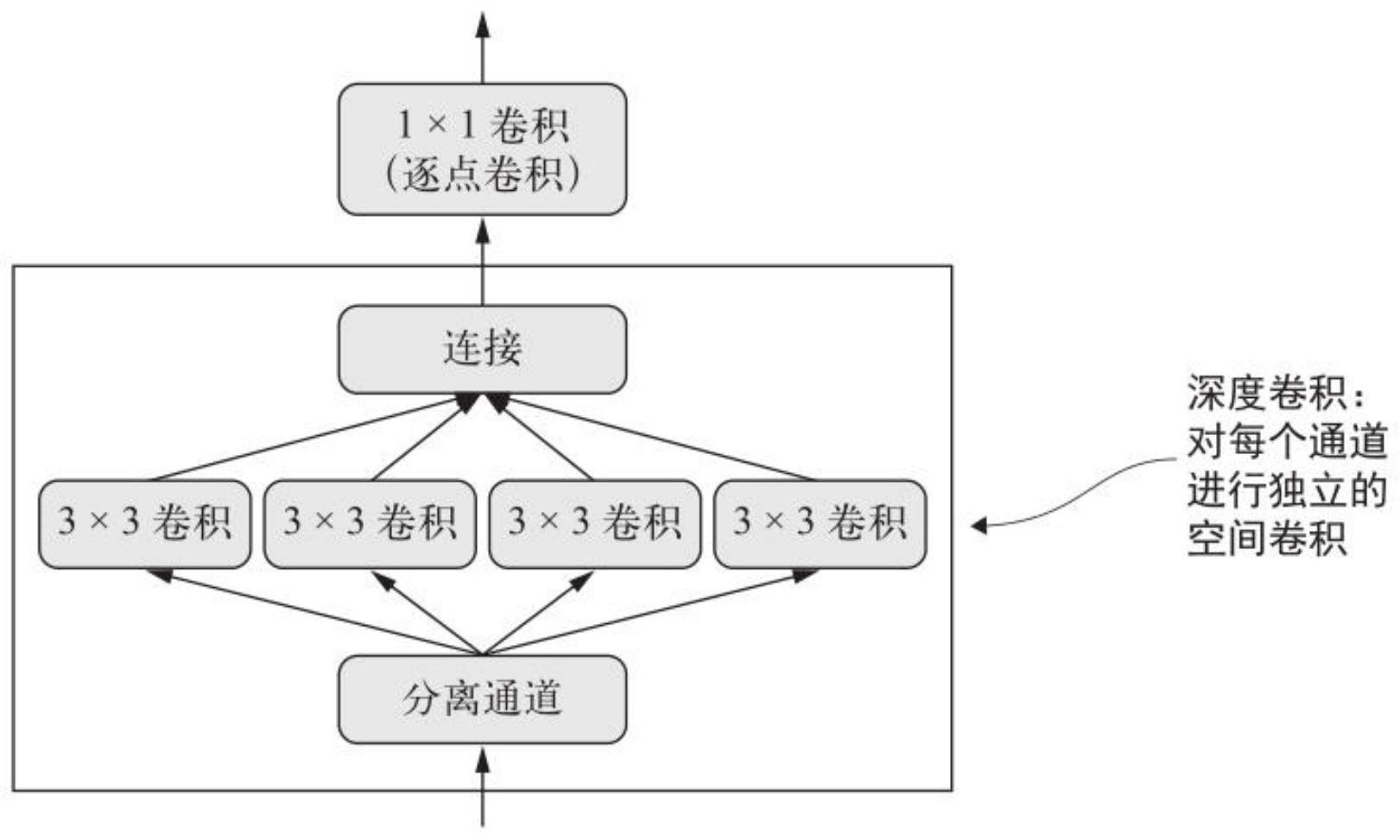

从卷积神经网络登上历史舞台开始,经过不断的改进和优化,卷积早已不是当年 的卷积,诞生了分组卷积(Group convolution)、空洞卷积(Dilated convolution或 trous)等各式各样的卷积。深度可分离卷积(depthwise separable convolutions)是 Xception以及MobileNet系列的精华所在,而它最早是由Google Brain的一名实习生 Laurent Sifre于2013年提出,Sifre在其博士论文中对此进行了详细的分析和实验。深度 可分离卷积对输入的每个通道分别执行空间卷积,然后通过逐点卷积(1×1卷积)将输出通 道混合。这相当于将空间特征学习和通道特征学习分开,如果假设输入中的空间位置高度 相关,但不同的通道之间相对独立,那么这么做是很有意义的。它需要的参数要少很多,计 算量也更小,因此可以得到更小、更快的模型。因为它是一种执行卷积更高效的方法,所以 往往能够使用更少的数据学到更好的表示,从而得到性能更好的模型。深度可分离卷积的 在运行速度和二维特征提取方面优异性能,将经典VGG16网络中普通卷积层替换后会使得 分类网络的训练速度和预测速度变得更快且准确率较高,但VGG16网络较深,如把全部普通 卷积层替换为深度可分离卷积层后网络训练较困难,所以还是需要使用预训练权重的方法 来进行迁移学习。

技术实现要素:

针对于现有的深度可分离卷积神经网络方法,本发明通过提出了一种改进VGG-16 网络来提高经典分类网络的训练速度和识别速度,VGGNet网络是由扭计大学和谷歌大脑的 研究员共同开发提出的,在ILSVRC-2014的比赛中得到了定位任务的第一名和分类任务的 第二名。由于其优异的性能使得VGGNet得以快速的流行。VGGNet模型中有一些变种,常见的 一些变种如表1所示,其中最后欢迎的是VGG16,即模型D,这是一个拥有16层的模型,模型的 输入维度为224*224*3. 表1 VGGNet 3 CN 111598157 A 说 明 书 2/6 页 理解VGG16模型的设计原理,首先要理解卷积神经网络两大特点: 1:局部连接 2:权值共享 深度:对于局部连接来说,每个神经元的输出就只和该神经元上一层周围的局部 神经元有关,这样就可以使得网络的参数大大降低,可以设计更深的网络模型,这样做肯定 有坏处,可能会丢失一些全局信息,但如果设计的网络结构很深,那么可以在高层对网络低 层的局部特征进行组合,最终得到全局特征。所以这似乎是一个很巧妙的特点,一方面局部 连接可能会丢失全局特征,但另一方面它又可以设计出更深的网络模型,从而得到全局特 征。深度对网络的性能极其重要,一般来说越深的深度网络性能也就越好,深度网络自然集 成了低、中、高层特征,可以表达出更丰富的特征和含义。在VGG系列模型中,网络深度达到 16-19层,是当时在论文发表前最深的深度网络,所以它表现出了极佳的性能。 宽度:对于权值共享来说,这里的权值指的是卷积核的权值,所谓共享指的是从一 个局部区域学习到的信息,应用到图像的其它地方去,即用一个相同的卷积核去卷积整幅 4 CN 111598157 A 说 明 书 3/6 页 图像。通过权值共享,使得网络中训练的参数大大减少,可以帮助训练更深的模型。其次,也 由于权值共享,一个卷积核也就只能学到相应的某个特征,所以需要设计多个不同的卷积 核来提取图像中不同的特征,卷积核的数量也成为卷积神经网络的宽度,在VGG16模型中, 最开始是64个卷积核,随着网络的加深,卷积核数量一直增加到512,是一个很宽的网络,所 以它最后的性能如此之强大也不足为奇了。 卷积核:同时可以发现,VGG模型中所有的卷积核大小均为3×3,使用3×3的小卷 积核堆叠代替大卷积核,主要有以下几个原因: (1)3x3是最小的能够捕获像素八邻域信息的尺寸。 (2)两个3x3的堆叠卷基层的有限感受野是5x5;三个3x3的堆叠卷基层的感受野是 7x7,故可以通过小尺寸卷积层的堆叠替代大尺寸卷积层,并且感受野大小不变。所以可以 把三个3x3的filter看成是一个7x7filter的分解中间层有非线性的分解,并且起到隐式正 则化的作用。 (3)多个3x3的卷基层比一个大尺寸filter卷基层有更多的非线性(更多层的非线 性函数,使用了3个非线性激活函数),使得判决函数更加具有判决性。 (4)多个3x3的卷积层比一个大尺寸的filter有更少的参数,假设卷积层的输入和 输出的特征图大小相同为C,那么三个3x3的卷积层参数个数3x((3x3xC)xC)=27C2;一个 (7x7xC)xC的卷积层参数为49C2。前者可以表达出输入数据中更多个强力特征,使用的参数 也更少。 不足是在进行反向传播时,中间的卷积层可能会导致占用更多的内存。 池化核:相比AlexNet的3x3的池化核,VGG全部采用2x2的池化核,可以保留更多的 图像信息。 全连接转卷积(测试阶段):这也是VGG的一个特点,在网络测试阶段将训练阶段的 三个全连接层替换为三个卷积层,使得测试得到的全卷积网络因为没有全连接的限制,因 而可以接收任意宽或高为的输入,这在测试阶段很重要。 卷积层和全连接层的唯一区别在于卷积层的神经元对输入是局部连接的,并且同 一个通道(channel)内不同神经元共享权值(weights) .卷积层和全连接层都是进行了一个 点乘操作,它们的函数形式相同.因此卷积层可以转化为对应的全连接层,全连接层也可以 转化为对应的卷积层。 比如VGGNet[1]中,第一个全连接层的输入是77512,输出是4096.这可以用一个卷 积核大小77,步长(stride)为1,没有填补(padding) ,输出通道数4096的卷积层等效表示, 其输出为11*4096,和全连接层等价.后续的全连接层可以用1x1卷积等效替代。简而言之, 全连接层转化为卷积层的规则是:将卷积核大小设置为输入的空间大小,这样做的好处在 于卷积层对输入大小没有限制,因此可以高效地对测试图像做滑动窗式的预测。但是, VGG16网络的训练速度和检测速度应该需要进一步提高。 本发明针对VGG16网络进行改进,达到提高经典分类网络的训练速度和识别速度 的目的,一种基于VGG16网络改进的图像分类方法包括以下步骤: 步骤1、获取图像数据集VOC2007数据集,进行数据预处理和训练集测试集的划分。 步骤2、构建基于VGG16改进后的卷积神经网络训练模型。 步骤3、利用划分好的训练样本集合进行模型的训练。 5 CN 111598157 A 说 明 书 4/6 页 步骤4、模型预训练权重调用。 步骤5、针对模型预测结果进行实验结果分析。 作为优选,步骤1具体包括以下步骤: 步骤1.1、通过公开数据集获取VOC2007数据集; 步骤1.2、进行数据校验,包括图像完整性和对应的类别标签; 步骤1.3、将数据集中的60000幅图像按5:1的比例随机划分为训练集和测试集,每 个训练集和测试集包括一幅图像和其对应的类别标签; 作为优选,步骤2具体包括以下步骤: 步骤2.1、首先搭建原始VGG16网络,作为对照实验模型; 步骤2.2、在VGG网络的基础上进行改进,将最后三层卷积曾替换为深度可分离卷 积层; 步骤2.3、设置训练过程中的dropout值为0.7,即在训练过程中,用于随机去除 30%的神经元,防止模型过拟合; 作为优选,步骤3具体包括以下步骤: 步骤3.1、将上述训练好的数据集维度大小调整为224*224*3; 步骤3.2、利用重新划分好维度的训练集进行模型训练,其中loss计算采用多分类 交叉熵计算方法,训练中的优化器采用rmsprop优化器; 步骤3.3、当网络迭代到损失值小于一定的阈值后,停止模型的训练,保存深度卷 积神经网络的模型; 步骤3.4、对于对照实验的训练进行上述相同操作; 作为优选,步骤4具体包括以下步骤: 步骤4.1、将权重模型中对应的最后三层卷积层权重剔除后,将其余部分加载到本 发明提出的模型中; 步骤4.2、对于对照实验的预训练权重调用,直接使用官方提供的权重模型; 步骤4.3、通过观察loss取消对比本发明提出模型的优化效果; 作为优选,步骤5具体包括以下步骤: 步骤5.1、观察本发明提出的方法和原VGG16方法的实验结果; 步骤5.2、对比优化前后模型在同一数据集上的loss曲线来分析优化效果。loss曲 线如图2和图3。其中图2为原VGG16的loss曲线。图3为本发明提出的优化模型loss曲线。分 析发现原模型的loss曲线下降平滑缓慢,而本发明的loss曲线下降快速且拟合较好。主要 原因为深度可分离卷积将空间特征学习和通道特征学习分开,从而导致需要的参数要少很 多,计算量也更小,可以得到更小、更快的模型。使用更少的数据学到更好的表示,从而得到 性能更好的模型。前期loss下降缓慢主要由于没有加载对应预训练权重导致。 与现有技术相对,本发明具有以下明显优势: 本发明通过修改经典分类网络的最后几层普通卷积层为深度可分离卷积层来提 高训练速度和识别速度,由于深度可分离卷积层的结构优势,使其可以很明显的提高速度 指标,但由于VGG16网络层数较多,需使用预训练方法训练网络。如全部替换为深度可分离 卷积层后没办法调用预训练权重,遂采取折中方法,替换原VGG16网络的最后三层普通卷积 层为深度可分离卷积层,即可以调用预训练权重又可以加快训练速度和识别速度。正是由 6 CN 111598157 A 说 明 书 5/6 页 于这两部分的优势结合并通过分析实验中的loss曲线对比可知,用深度可分离卷积层改进 后的网络在速度指标上与原普通卷积层的VGG16相比有明显改善,准确率和原网络相当。 附图说明 为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现 有技术描述中所需要使用的附图和表作简单地介绍,显而易见地,下面描述中的附图和表 仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提 下,还可以根据这些附图获得其他的附图和表。 图1为深度可分离卷积神经网络介绍; 图2为原VGG16的loss曲线; 图3为本发明提出的优化模型loss曲线。