技术摘要:

本发明公开了一种多音字读音预测方法,涉及计算机语音处理技术领域,旨在解决现有技术中多音字读音标注准确率低的问题。其技术方案要点是获取大量包含多音字的文本及其拼音全拼;使用批量迭代训练的方法,在所设计的模型上进行训练,得到多音字预测模型;在文本读音标 全部

背景技术:

语音合成,一种让计算机根据文本内容合成相应语音的技术,能够让机器开口说 话,是提升人机交互体验的关键。当前,深度学习技术也进入了语音合成领域,并且取得了 不错的效果。本发明用于将带有多音字的汉语文本转成正确的拼音,是语音合成的关键步 骤。 此前对多音字的读音预测方法主要有:1.直接按照频率最高的读音,显然这种方 法准确率较低;2.总结多音字词库和语料库,然后用词组匹配的方法处理多音字,但是这种 会受限于语料库的大小,语料库太大又会引入匹配歧义错误,纯用词组库也无法解决单个 字或词语有多种读音的情况;3.语言学家制定规则,然后结合规则和决策树等机器学习方 法训练模型识别,但规则制定较为困难。因此,现有的多音字读音预测准确率较低。

技术实现要素:

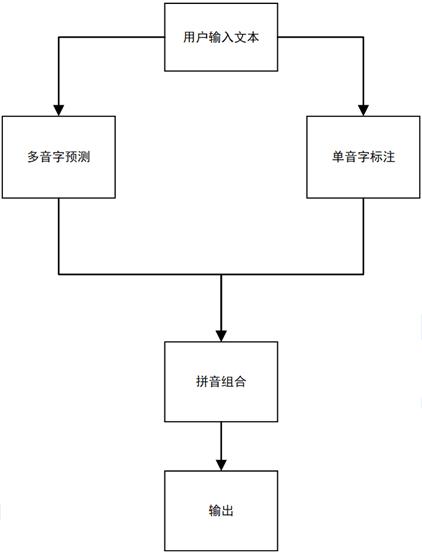

本发明的目的是提供一种多音字读音预测方法、装置及计算机可读存储介质,利 用深度神经网络学习文本的上下文信息,对多音字读音进行预测,能够提高多音字读音预 测的准确度。 本发明的上述发明目的一是通过以下技术方案得以实现的: 一种多音字读音预测方法,包括以下步骤: 将输入文本导入训练的多音字预测模型中,获取多音字在输入文本中的读音; 将输入文本进行单音字读音标注,获取单音字读音; 将单音字读音和多音字读音按照文本顺序进行组合,输出整个文本读音;其中, 多音字预测模型的训练包括以下步骤: 输入包含多音字的训练文本,标注对应的正确读音,输出训练文本对应的数据文本;将 数据文本输入到预训练语言模型,获取数据的向量表示;将向量输入深度学习模型进行批 量迭代训练,获得多音字预测模型; 标注对应的正确读音包括将训练文本中的多音字按照正确读音标注,单音字用符号标 注。 本发明进一步设置为:深度学习模型包括有循环与输入向量进行卷积操作,获得 多音字所在位置上下文分别进行卷积操作得到的两个向量,将这两个向量进行拼接后输入 GRU网络中进行重置和更新,将GRU网络输出向量进行随机失活,输出多维向量,将输出的多 维向量转换为一维向量,通过函数将一维向量各个元素映射到各个读音对应的概率,输出 概率最大的读音。 本发明进一步设置为:预训练模型为Word2vec或bert模型。 本发明进一步设置为:多音字预测模型的训练包括在每次迭代时采用随机梯度下 4 CN 111599340 A 说 明 书 2/6 页 降算法训练模型,采用交叉熵损失函数评价模型拟合的程度。 本发明的上述发明目的二是通过以下技术方案得以实现的: 一种多音字读音预测装置,包括: 多音字预测模块,用于将输入文本导入训练的多音字预测模型中,获取多音字在输入 文本中的读音; 单音字读音标注模块,用于将输入文本进行单音字读音标注,获取单音字读音; 读音组合模块,用于将单音字读音和多音字读音按照文本顺序进行组合,输出整个文 本读音。 本发明进一步设置为:多音字预测模块包括: 输入层,输入包含多音字的训练文本,标注对应的正确读音,输出训练文本对应的数据 文本; 预训练层,用于将标注文本输入到预训练语言模型,获取数据的向量表示; 卷积层,用于循环与预训练层输出向量进行卷积操作,获得多音字所在位置上下文分 别进行卷积操作得到的两个向量; 拼接层,用于将卷积层输出的两个向量进行拼接; GRU网络层,用于有选择地对拼接层输出的向量进行重置和更新; Dropout层,用于将GRU网络层输出向量进行随机失活; 全连接层,用于将Dropout层输出的多维向量转成一维向量; 输出层,用于利用函数将全连接层输出的向量元素映射到各个读音对应的概率,输出 概率最大的读音。 本发明进一步设置为:多音字预测模块包括在每次迭代时采用随机梯度下降算法 训练模型,采用交叉熵损失函数评价模型拟合的程度。 本发明进一步设置为:包括有语音合成模块,用于将读音组合模块输出的读音合 成语音,输出音频。 本发明的上述发明目的三是通过以下技术方案得以实现的: 一种计算机可读存储介质,包括一组计算机可执行指令,当指令被执行时用于执行上 述的一种多音字读音预测方法。 综上,本发明的有益技术效果为:获取用户输入的文本,检测其中的多音字位置, 并对其读音进行预测,并查表获取单音字拼音,拼接输出文本对应的拼音,结合词库和深度 学习两种技术,能够提高多音字转拼音的准确度。 附图说明 图1是本发明实施例一的整体流程图; 图2是本发明实施例一中多音字预测模型的训练流程图; 图3是本发明实施例二的整体结构框图; 图4是本发明实施例二中多音字预测模块的结构框图。