技术摘要:

本发明提供一种基于无监督学习的模型预训练方法。本发明首先采用均匀分布的方式对神经网络模型的参数进行初始化,并设置循环轮数;利用数据本身具有高度相似性的特点,寻找锚数据;然后利用最近邻算法为每个锚数据寻找邻数据;再拉近锚数据和其对应的邻数据在特征空间 全部

背景技术:

随着深度神经网络的兴起,日常生活中,越来越多的地方用到了深度学习的方法, 比如:人脸识别、自动驾驶、智能零售等。但是,就目前来看,深度学习的方法都无可避免的 要使用大量有标签的数据进行训练,从而使模型达到优良的性能。并且,随着人们所面临的 任务量的增加,导致网络越来越深,对有标签的数据量的需求也越来越大。 众所周知的是,对数据进行标记标签是一件非常枯燥、特别消耗成本、影响工程项 目进度推进的事情。所以,当今比较普遍的一种做法是,给深度神经网络模型加载预训练参 数,使其在目标数据集上进行训练之前,模型已经具备初步的能力,以达到减少对带标签数 据量的需求,在实际应用中,这种做法还能使模型的性能得到较好的提升,还可以大大节省 开发周期。 当前比较流行的模型的预训练方法主要有2种: 一种是加载已有训练好的模型参数,作为目标数据集的初始化。著名的有 ImageNet训练好的ResNet34、ResNet50、ResNet101等,这种方法简单、高效。但同时缺点也 很明显,非常受限于模型框架,倘若你要自己设计一个模型,那么现有的已经训练好的模型 参数都无法派上用场。另外,还有一个特别突出的缺点就是,目前这种预训练方法都很依赖 于ImageNet数据集,原因是ImageNet数据量庞大且较为丰富。可是,倘若我们想做一个车辆 识别相关的工作,那么这种预训练方法也将不能起到很好的初始化作用。原因也很简单,因 为ImageNet收集的信息中绝大部分信息均与车辆无关,因此以这种方式进行目标域为车辆 的识别工作可能会起到反作用,影响模型学习的方向。 另一种预训练方法就可以比较好的避免上一种方法中遇到的问题,即采用无监督 学习对模型在目标数据集进行有针对性的初始化。那么,自然而然的,就会想到如何利用好 现有的无监督学习算法。目前在该领域比较具有代表性的方法有Kmeans和DBSCAN。然而, Kmeans和DBSCAN均需要人为设置K值和密度值,这些参数的设置将严重影响实验结果的好 坏。 本文提出的是一种新型的基于数据本身相似度特性进行特征聚类的方法,该方法 可以很好的进行无监督聚类,解决了Kmeans和DBSCAN中难以设置的K值和密度值的问题,并 且可以达到和ImageNet作为初始化进行直接测试的效果。我们相信,我们所介绍的新型的 无监督学习作为深度神经网络模型预训练是切实可行且具有非常明显的现实意义的。

技术实现要素:

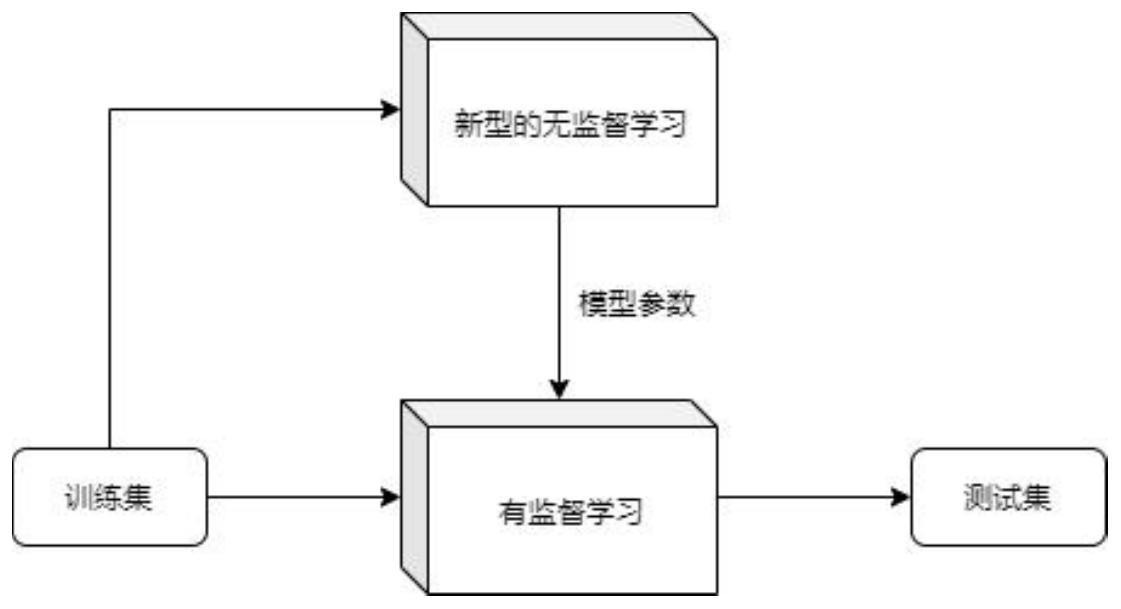

针对现有技术中存在的不足,本发明提供一种基于无监督学习的模型预训练方 4 CN 111612146 A 说 明 书 2/4 页 法。 本发明主要研究的是深度神经网络模型的参数初始化,需要解决的技术问题有: 如何采用一种更加有效的着眼于目标数据集本身的无监督学习进行深度神经网络模型参 数初始化。 本发明的灵感来自于,近期有研究表明,数据本身之间具有高度相似性,即相同类 别的两副图像之间的相似度比不同类别的两幅图像的相似度要高。许多学者依据此发现进 行了大量的相关研究。本发明依据最新的无监督学习作为深度神经网络模型的参数初始化 (预训练),为加速模型的训练,节省工程开发周期、提高深度学习算法准确率起到明显作 用,具有十分重要的现实意义。 本发明方法步骤如下: 步骤1、采用均匀分布的方式对神经网络模型的参数进行初始化,并设置循环轮 数; 步骤2、利用数据本身具有高度相似性的特点,寻找锚数据; 步骤3、利用最近邻算法为每个锚数据寻找邻数据; 步骤4:拉近锚数据和其对应的邻数据在特征空间之间的距离; 步骤5:采用循序渐进的方式,循环步骤2-步骤4,获得最终的神经网络模型参数; 步骤6:将获得的最终的神经网络模型参数作为后续针对目标数据集进行监督学 习的初始化参数; 本发明方法具有的优点及有益结果为: 1、介绍了一种基于数据本身相似度特性的无监督学习方法,可以很好应用于各式 各样的数据集,所提算法的适用性广泛。 2、采用循序渐进的方式,让算法能自身从简单到复杂进行学习,不断提升无监督 学习效果。 3、本发明最终将新型的基于数据本身相似度特性的无监督学习应用于神经网络 模型的预训练,作为网络的初始化参数,为后续在目标数据集上进行监督学习节省了训练 时间、提升了模型准确率。 附图说明 图1是本发明在目标数据集中寻找锚数据的展示图; 图2是本发明利用最近邻算法为锚数据寻找邻数据的展示图; 图3是本发明中拉近锚数据和邻数据之间特征距离的展示图; 图4是本发明采用新型的无监督学习作为模型预训练的框架图;